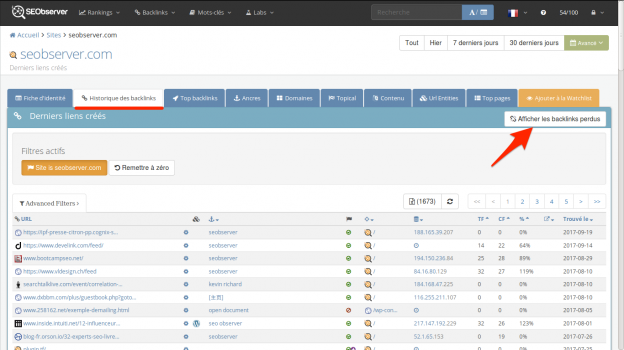

Les backlinks perdus

En effet, la « perte » d’un backlink est parfois simplement due au fait que le lien a changé de page, à cause par exemple de la pagination d’un blog ou d’un forum. Ou encore si un lien qui se trouvait dans un flux rss disparaît de ce flux, tous les indicateurs s’allument au rouge alors que le lien n’a finalement pas bougé de son article de base.

Cela provoque du stress inutile puisque l’information essentielle est finalement de pouvoir savoir s’il reste encore des backlinks sur le site en question et si oui sur des pages importantes ou non.

Déterminer qu’un backlink est bel et bien « perdu » est donc une discipline qui est plus délicate qu’elle en a l’air: détecter la présence d’un lien est relativement facile, en revanche, être catégorique sur la disparition du lien est beaucoup moins évident.

Le nombre de backlinks restants permet de constater si le ou les backlinks perdus étaient les derniers ou non sur le site, ce qui change absolument tout dans l’analyse que vous pourrez faire de vos backlinks perdus.

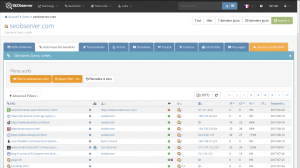

Il est souvent difficile d’analyser ses nouveaux backlinks de manière efficace dans les outils de netlinking, nous sommes souvent pollué par le spam sans pouvoir y faire grand chose.

Notre approche a donc été de développer une fonctionnalité qui permette à la fois de filtrer ce spam en sélectionnant directement les sites que l’on ne veut plus voir dans la liste des backlinks. Et également d’importer/exporter un fichier de désaveu pour maintenir à jour les domaines désavoués auprès de Google.

- Afficher des options supplémentaires pour importer/exporter et ajouter manuellement des sites à filtrer.

Ce dernier point est très important, nous avons voulu laisser le choix de faire un filtre « par site », ou d’avoir un filtre par défaut pour tous les sites (beaucoup plus pertinent si vous êtes propriétaire de plusieurs sites et que vous souhaitez ajouter dans un filtre/fichier commun les sites à masquer/désavouer).

Google Fred: aperçu de l’impact sur google.fr

D’habitude nous essayons de toujours vous proposer des belles études avec plein de données expliquées et décortiquées à l’intérieur, actionnables mais cette fois-ci par manque de temps notre contribution va s’arrêter à de la donnée brute, non interprétée, et vous laisserons tirer les conclusions s’il y en a à tirer.

Les clients SEObserver pourront toujours utiliser la SERPmachine et la Trafficmachine pour avoir une présentation plus claire et ergonomique et voir ce qui s’est passé sur les SERPs qu’ils suivent.

Voici donc le csv brut de l’ensemble des différences de + ou – 10 places sur les premières places du top 1000 mots-clés sur google.fr entre le 5 mars 2017 et le 15 mars 2017.

Cela signifie par exemple qu’un site qui était dans les 20 premiers et qui subit baisse de 10 places ou plus sera listé. Idem pour un site qui entre dans le top 20 avec une différence de ranking de 10 places. Cela permet d’identifier les plus gros mouvements.

Cliquez ici pour télécharger fred_diff.csv (581 Ko) et n’hésitez pas à partager vos analyses, nous les relaierons autant que faire se peut.

SEObserver v2 : les nouveautés qui vous attendent

Chers amis,

Nous avons présenté les nouveautés de la v2 de SEObserver dans un podcast live hier soir. Pour ceux qui n’ont pas pu le voir, voici un résumé de ce qui change dans l’outil.

Augmentation du tronc commun

Le tronc commun passe de 50.000 SERPs suivies à plusieurs millions (2,000,000+). Nous aurions pu aller encore plus loin, mais d’après nos tests, ce n’est pas nécessaire puisque que notre but est d’avoir une exhaustivité des mots-clés à forts potentiels. Nous récupérons les SERPs de tous les mots-clés qui font au moins 100 recherches par mois et qui ont un intérêt business.

L’intérêt concret ? Nous trouvons les mots-clés sur lesquels vous n’êtes PAS ENCORE positionnés. Souvent on ne vous montre que le top 10 ou le top 20, des mots-clés pour des sites en particulier, résultat : si vous êtes 21ème sur « rachat de credit » ou « assurance auto », cette donnée est invisible pour des outils classiques. Mais nous, nous le voyons. Ainsi, vous pouvez concentrer vos efforts rédactionnels ou de netlinking vers des gros mots-clés sur lesquels vous montez mais n’êtes pas encore au top.

Le tronc commun permet de faire une analyse immédiate dans l’outil et de remonter dans le temps, il nous a permis de sortir la Trafficmachine, et également le Volatility explorer (nous y revenons plus bas dans cet article).

Le plus important: on a de l’HISTORIQUE sur ces millions de mots-clés. Et cette donnée sera toujours ACCESSIBLE dans son intégralité.

Augmentation du nombre de mots-clés perso

Nous passons les plans freelance et studio à 1500 et 5000 SERPs perso dans vos campagnes. Oui, ça fait un x10 sur votre nombre de mots-clés suivis, et alors ? (Nous sommes actuellement en train déployer cette mise à jour, si votre compte n’est pas encore à jour contactez-nous au support !)

Localisation des mots-clés personnalisable

Désormais vous pouvez suivre vos mots-clés en vous géolocalisant dans le pays ou la ville de votre choix, sur l’extension Google de votre choix. C’est un pas de plus vers la sortie officielle de l’outil à l’international qui arrive à grands pas. Vous verrez d’ailleurs de plus en plus de morceaux d’interface en anglais, qui seront par la suite re-traduits en français, car nous remettons tout à plat également de ce côté-là.

Rafraîchissement automatique

Dès que vous visitez la SERPMachine d’un mot-clé la SERP est rafraîchie en instantané si le dernier relevé a plus de 24h, donc à chaque fois que vous visitez un mot-clé, les résultats dateront toujours du jour même.

Création des campagnes

Nous avons créé un outil bien plus efficace que le précédent pour suivre ses mots-clés et ses sites. A découvrir immédiatement ! Découvrez également l’environnement des campagnes, qui vous permettra de garder toujours un oeil sur les serps !

Trafficmachine

On s’est dit la SERPmachine c’est bien, mais comment faire pour analyser les parts de marché avant/après ? Vous pouvez maintenant savoir ce qu’il se passe sur des groupes de mots-clés ! Donc il devient facile d’analyser ce qui se passe sur un ensemble de mots-clés cohérents entre eux. Par exemple vos mots-clés marques (qui monte sur mon nom ?) ou au contraire vos mots-clés transactionnels.

Volatility Explorer

Le volatility explorer permet enfin de voir exactement les mots-clés qui bougent dans un groupe de mots-clés. Pratique pour gagner en « hauteur de vue » sur les mouvements dans les SERPs.

Exclusivité mondiale: l’historique du TrustFlow

Désormais, le TrustFlow au niveau du domaine est archivé. Cela vous permettra de consulter sur une grande quantité de sites l’évolution avec le temps du nombre de backlinks, du TrustFlow et du nombre de referring domains. Nous sommes les seuls à avoir cette métrique sur plusieurs millions de domaines, personne d’autre ne la possède, pas même Majestic notre fournisseur officiel ! L’historique des metrics majestic, vous permettra encore mieux de savoir ce qu’il se trame chez vos concurrents !

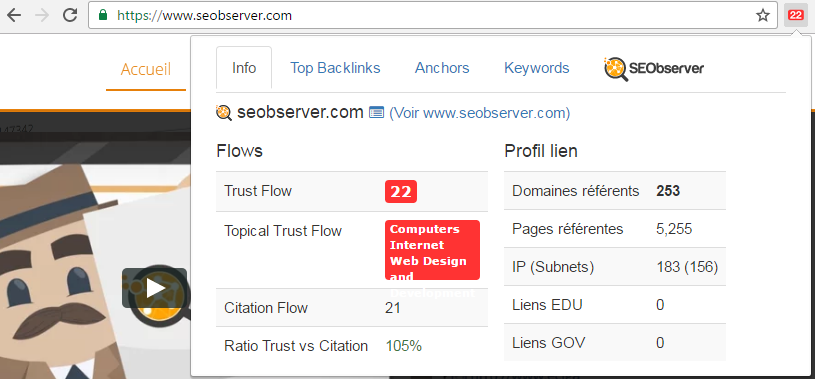

TF Toolbar

Pour remplacer l’extension « PageRank » de Google, nous avons créé une extension Chrome et Firefox qui affiche en instantané le TF du domaine en cours, à chaque consultation d’url, avec sa catégorie de « Topical Trust Flow ». Personne d’autre ne propose cela, pas même Majestic qui livre un plugin où il faut cliquer pour avoir les stats, mais nous sommes fainéants et un clic c’est déjà trop ! Ce plugin est vraiment addictif, et l’essayer c’est l’adopter.

L’extension, permet d’analyser les sites en permanence, et vous emmène en deux clics dans la fiche d’identité si vous souhaitez en savoir encore plus !

Pour les non-abonnés SEObserver, une version premium de ce plugin existe et elle coûte 99€/an. Pour vous c’est évidemment gratuit.

Domain Extractor

L’intérêt d’avoir la donnée majestic directement dans l’outil nous permet d’analyser en permanence cette donnée et de l’utiliser à notre avantage, le Domain Extractor est la preuve que le mélange des données de rankings et de netlinking nous permettent de tamiser des pépites d’or ! A découvrir de toute urgence !

Keyword Competition Checker amélioré

L’analyse de la difficulté d’une SERP n’a jamais été aussi précise grâce à notre module d’analyse de SERP. Nous incluons les données backlinks de Majestic, les données traffic de SEMrush et également les données sémantiques trouvées lorsque l’on scanne les sites. Vous pouvez ainsi trouver les termes les plus employés par les 10 premiers sites d’une SERP.

Ah oui, et nous vous proposons aussi les mots-clés similaires au mot-clé en cours grâce à une méthodologie innovante qui nous permet de connaître les VRAIES mots-clés similaires.

(Prochainement) Les tutos vidéos

A quoi cela sert de vous livrer une arme atomique si on ne vous explique pas concrètement comment vous en servir ? De manière régulière les tutos sous forme de screencast vont être publiés pour vous permettre d’utiliser l’outil de manière de plus en plus puissante.

Le prix

La question la plus problématique est toujours celle du prix…

De ce côté là, rien ne change !

NOUS GARDONS EXACTEMENT LE MÊME PRIX pour les abonnés actuels, à vie

En revanche, nous ne savons pas comment cela va évoluer dans les prochains mois : en théorie, le prix doit être proportionnel au service : si nous augmentons les features, les limites et les données d’archive, le prix va tôt ou tard augmenter, sauf pour les clients actuels. Monter dans le train maintenant, c’est garantir sa place et verrouiller un prix à vie, malgré les futures augmentations.

Nouveau client ?

Pour ceux qui voudrait prendre le train en marche, il est possible jusqu’à ce soir minuit de profiter du même avantage que nos clients. Rendez-vous sur https://www.seobserver.com pour en savoir plus.

Les atouts de SEObserver

- C’est un outil SEO conçu et amélioré par des consultants.

- Il permet de s’auto former en SEO, et de découvrir les stratégies qui fonctionnent en analysant les SERPs.

- C’est une solution tout-en-un, vous pouvez lâcher vos abonnements à vos fournisseurs de backlinks et fournisseurs de rankings.

SEObserver v1.1, les nouveautés qui vous attendent

Résumé : 2 mois après la sortie, suite à vos retours, nous multiplions par 30 le nombre de mots-clés perso que vous pouvez monitorer et nous ajoutons des features très puissantes dédiées à l’analyse de backlinks.

SEObserver est né il y a un peu plus de deux mois, pour ceux qui auraient raté quelques épisodes voici ses quatre piliers principaux :

- accès aux 130 premières positions des 50 000 mots-clés les plus recherchés en France grâce à la SERPmachine (inclut un historique qui permet de remonter jusqu’à 1 an en arrière suivant les mots-clés.)

- accès au détail des backlinks des sites internet (quota en fonction de votre abonnement),

- accès à une fiche d’identité pour chaque site qui regroupe des données de rankings et de backlinks.

- un outil fait par et pour les SEO qui doit impérativement constamment s’adapter aux besoins des utilisateurs (je m’inclus dedans).

Votre outil n’a pas fini d’évoluer, j’essaie d’être au maximum à l’écoute de vos retours et mon but est de l’améliorer sans cesse. Du coup, j’en ai profité pour bosser au cours des semaines passées, et développer des features à partir de vos retours.

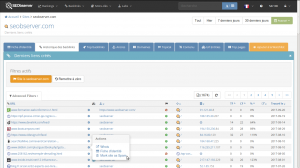

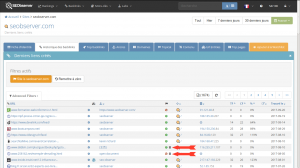

1) Amélioration de la vue backlinks

Votre souhait : naviguer dans les backlinks plus rapidement, sans avoir besoin de regarder le détail de chacun des backlinks.

Notre réponse : nous avons ajouté deux vues supplémentaires (Referring Domains et Thématiques) et nous avons amélioré la vue Ancres. Ces vues sont, je peux le dire, parmi les plus puissantes sur le marché du logiciel SEO pour faire des analyses à la vitesse de l’éclair.

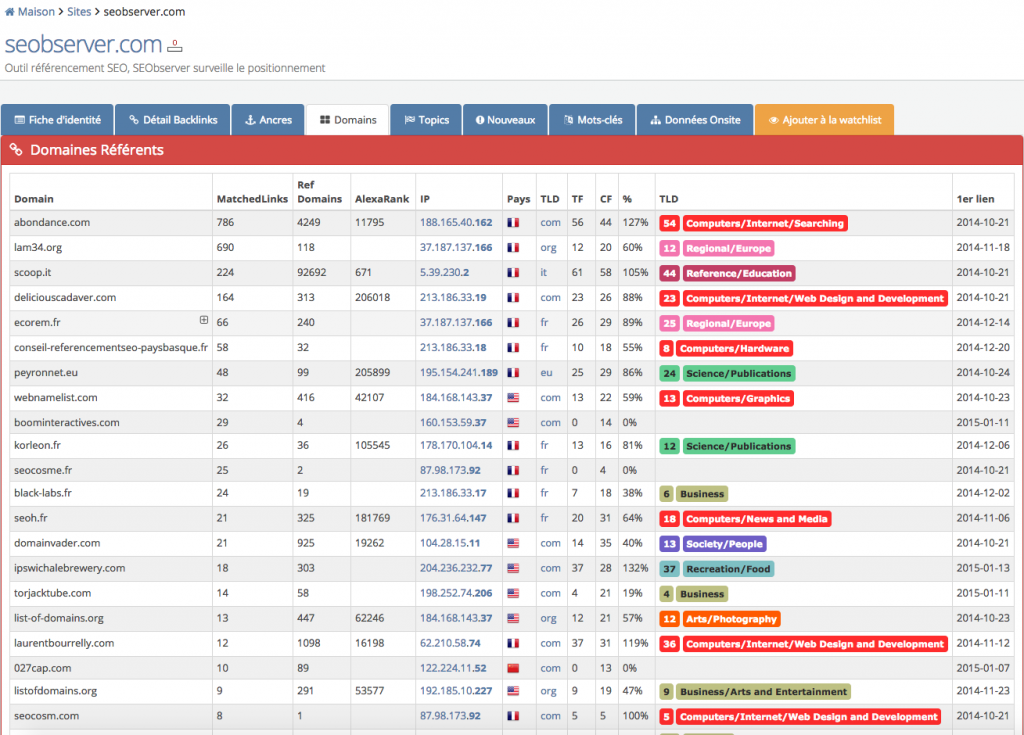

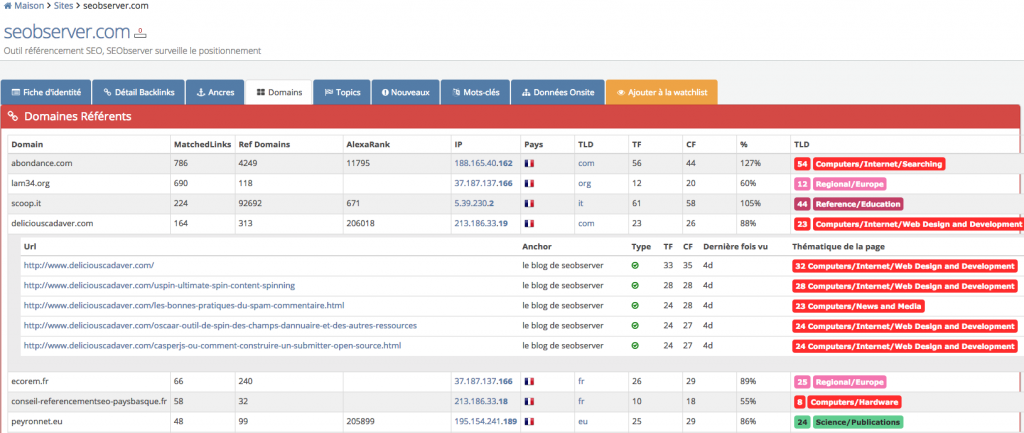

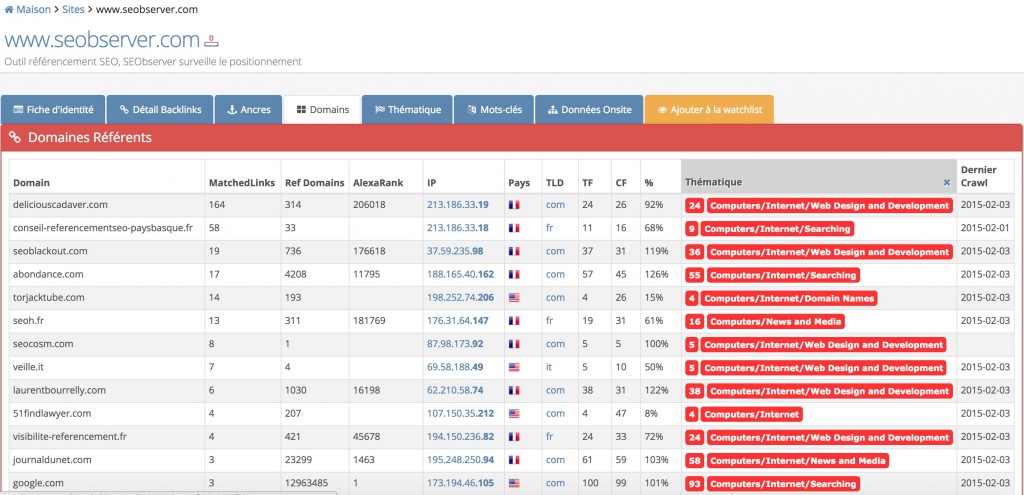

Voici la nouvelle vue referring domains.

En quelques mots :

- Le tri peut s’effectuer sur chaque colonne,

- Filtrage possible : par classe C, par IP, par localisation, par tld,

- Grosse nouveauté, vous pouvez filtrer par thématique du domaine, grâce à l’intégration du Topical Trust Flow (Trust Flow Thématique).

Si vous voulez afficher le détail d’un domaine référent, nous vous sortons les 5 backlinks les plus intéressant en provenance de ce domaine, en un clic.

Il y a une chose que l’on ne voit pas sur les screenshots, c’est la vitesse d’exécution, l’outil affiche ces données de manière instantanée.

Si vous aviez l’habitude d’attendre lorsque vous analysiez un profil de liens, avec SEObserver, vous n’aurez plus le temps de vous faire un café.

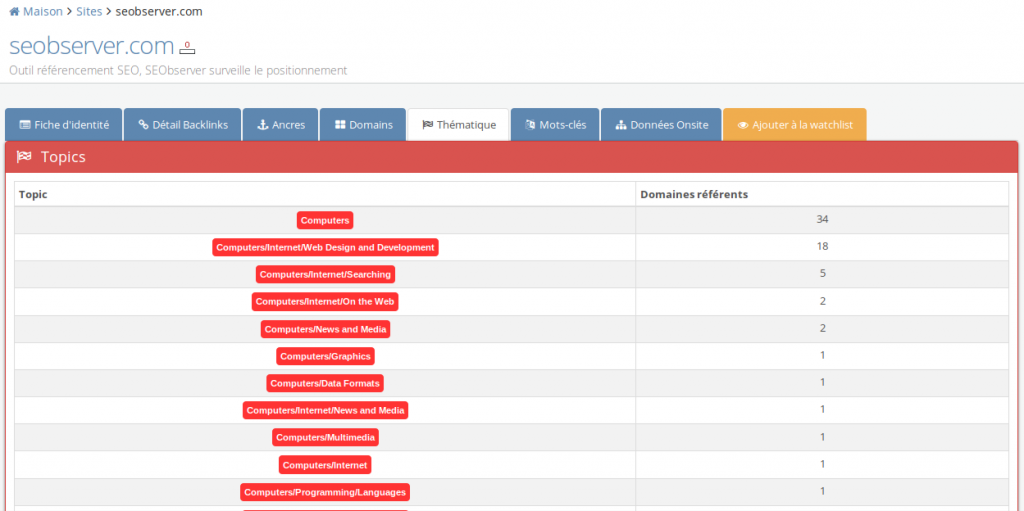

2) Création de la vue “thématique”

La vue thématique vous offre une toute nouvelle façon de visualiser les backlinks d’un site, et l’avantage très concret et très immédiat est le suivant : si vous voulez récupérer les backlinks de vos concurrents mais seulement ceux qui proviennent de sites uniquement dans la même thématique, vous pouvez tout filtrer en un clic.

Un clic sur la thématique et vous pourrez voir les domaines qui correspondent à celle-ci, en analysant soit par catégorie, soit par sous-catégorie.

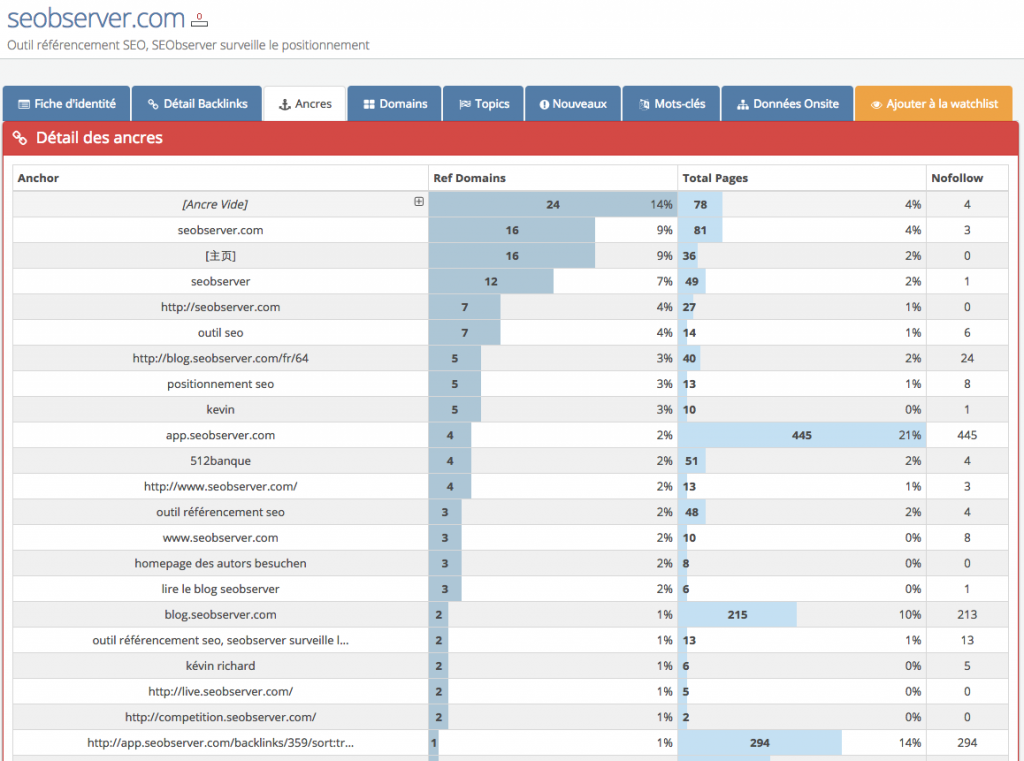

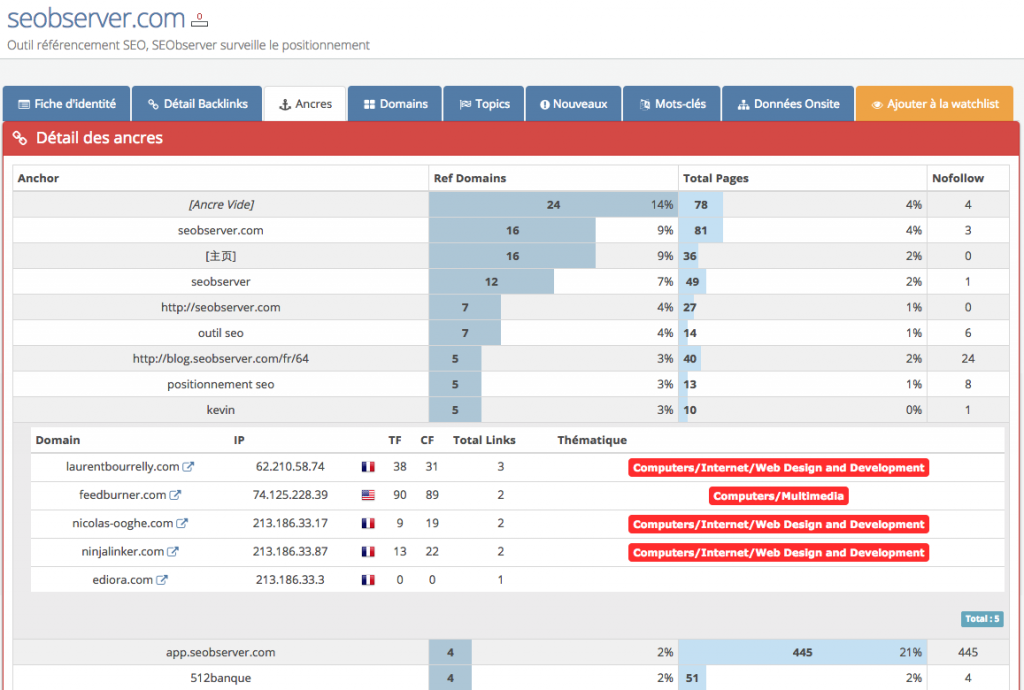

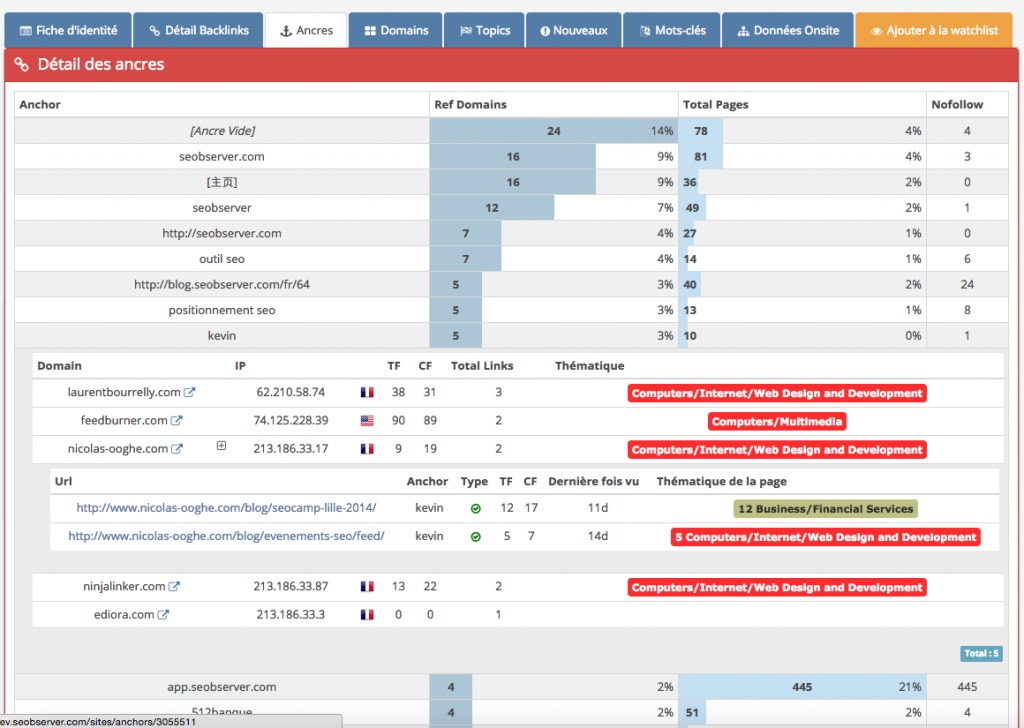

3) La vue par ancres

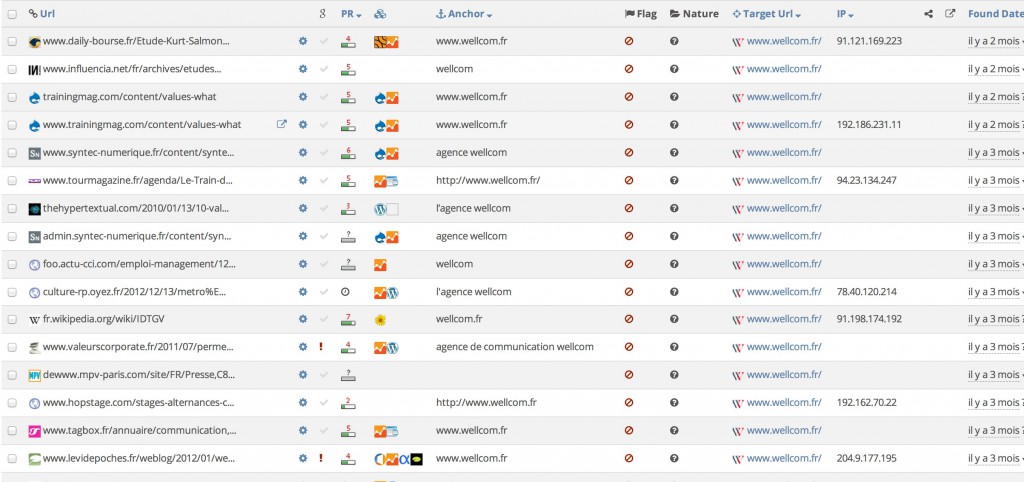

La vue Ancres a été améliorée. Pour rappel il s’agit de cette vue :

Avant il était seulement possible de voir la liste des ancres, désormais nous affichons le détail des domaines référents, pour chaque ancre :

Pourquoi s’arrêter en si bon chemin ? Un clic plus loin et vous avez accès à des exemples de backlinks, comme sur la vue referring domains.

Désormais vous pouvez cliquer sur une ancre pour afficher le détail des domaines qui contiennent un backlink au moins avec cette ancre. Cerise sur le pompon, vous avez même la thématique de la page qui s’affiche en fin de tableau.

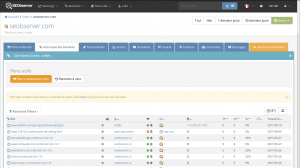

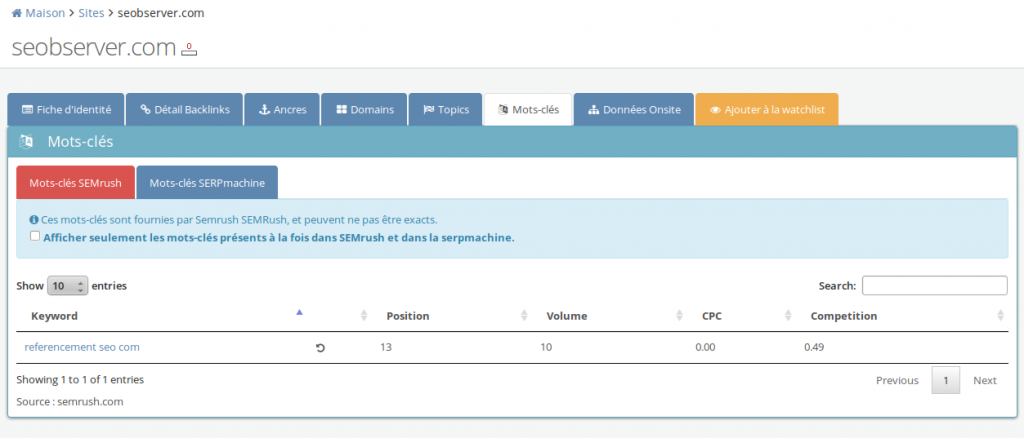

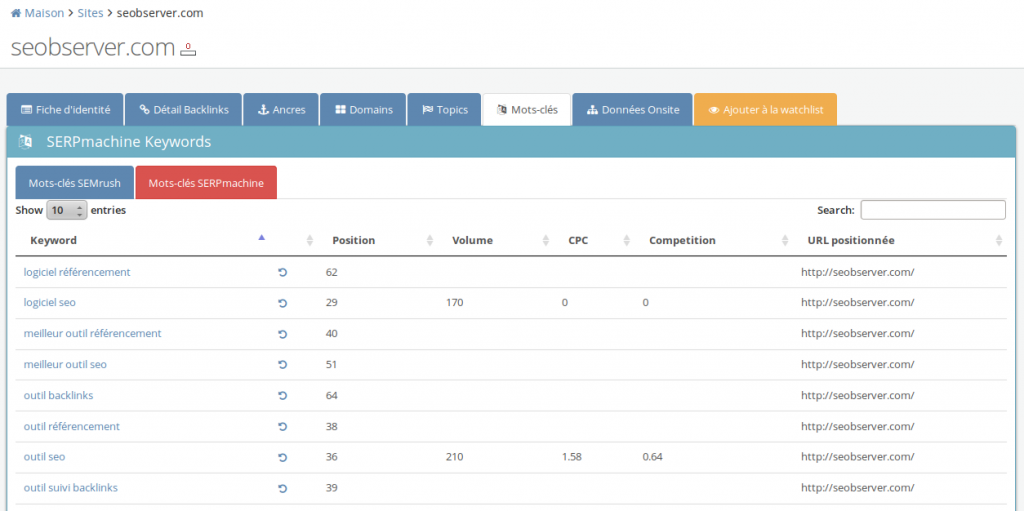

4) Savoir quels sont les keywords présents dans la SERPmachine

Vous souhaitiez connaître pour un site, tous les mots-clés présents dans la SERPmachine, c’est maintenant possible !

Avant nous n’affichions que les mots-clés présent dans SEMrush ET dans la SERPmachine. Le souci avec ce genre d’outils qui monitorent un énorme nombre de mots-clés, c’est qu’ils ne restent que dans les deux premières pages. Si vous êtes 21ème sur “assurance auto”, vous êtes donc invisibles pour eux. Pas pour nous.

Du coup, les jeunes sites en phase de croissance restent sous la plupart des radars, mais pas le nôtre En analysant, certes moins de mots clés, mais les mots-clés qui comptent, vous pouvez voir facilement quels sont les top mots-clés sur lesquels un site se positionne. C’est également excellent si vous souhaitez racheter un site internet, afin de voir son vrai potentiel (à condition qu’il ranke toujours). D’ailleurs, rien ne nous empêche, dans un futur proche, si la demande est au rendez-vous de vous afficher la liste des mots-clés pour lesquels un site rankait à un jour donné, dans le passé (coucou les gens qui achètent de l’expiré :))

Bref, rester cantonné aux 20 premiers résultats était affreusement frustrant, mais ça c’était avant, avec SEObserver vous enfilez votre tenue de plongée (ou plutôt nous plongeons à vôtre place) et on vous trouve les mots-clés sur lesquels vous ne vous attendiez peut-être même pas à ranker :

Dans cette vue, vous pourrez donc voir tout ceux qui disposent d’une archive et analyser les serps entières.

Il sera bientôt possible d’analyser plusieurs mots-clés en même temps directement depuis la fiche d’identité.

Ah oui, on s’est aussi dit que c’était important d’avoir l’url exacte positionnée sur le mot-clé. Pratique pour voir quelles sont les top urls d’un site

5) Le labs

Un nouvel onglet est apparu sur SEObserver, c’est le labs, vous y découvrirez des nouveautés très souvent en béta, elles évoluerons au fil du temps, et celles qui seront le plus appréciés deviendront des fonctionnalités à part entière.

N’hésitez pas à nous proposer de nouvelles fonctionnalités, nous devons améliorer notre outil pour en faire l’outil seo ultime (un outil pour tous les dominer).

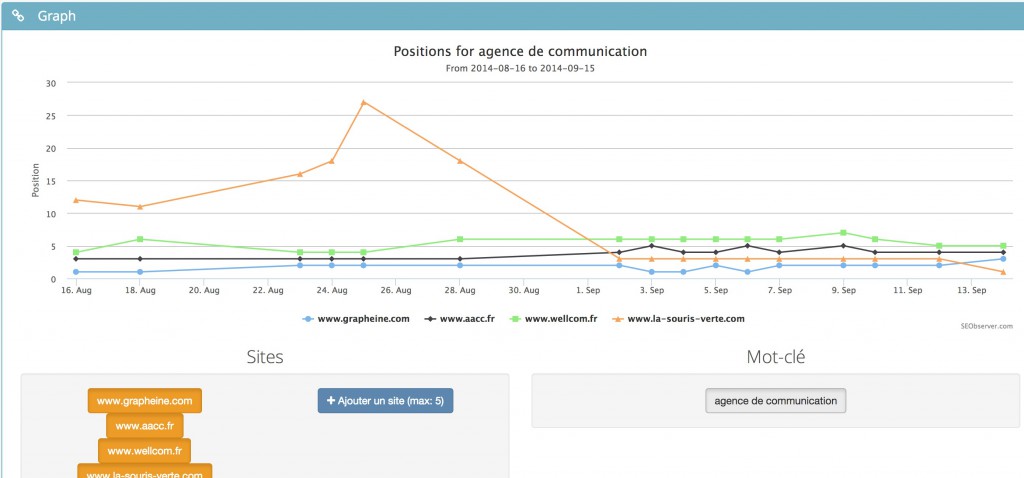

Vous pouvez découvrir dès maintenant la combi view, qui vous offre la possibilité de voir sur un même graphique, le ranking et les backlinks d’un site.

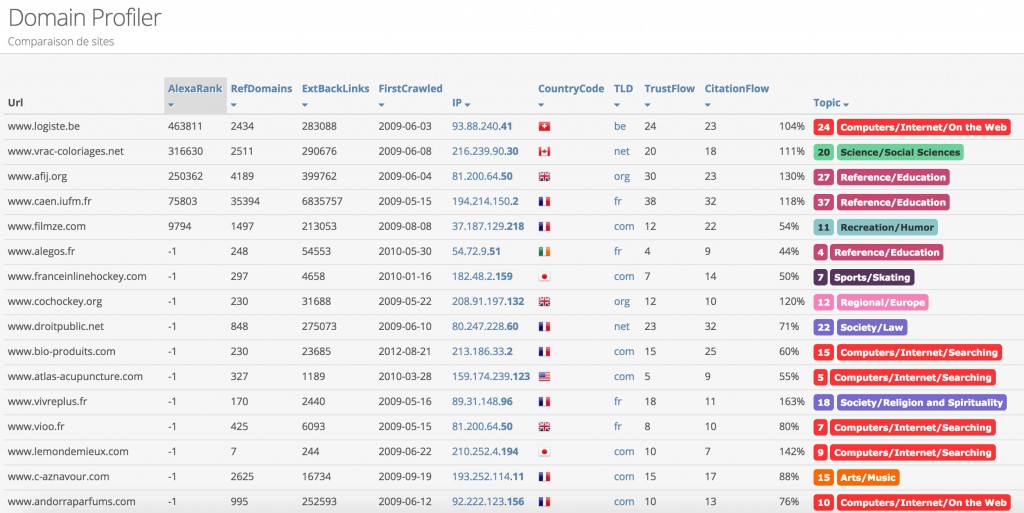

Mais également deux autres outils : un comparateur de sites, et un domain profiler.

Le domain profiler vous permet d’analyser en quelques secondes un grand nombre de domaines (1000+), dans le cas de rachat d’expirés par exemple. Vous avez toutes les métriques essentielles à portée de clic, données que vous pouvez ensuite trier et filter.

6) Ajout de mots-clés

Une autre nouveauté que vous attendiez tous, la possibilité d’ajouter vos mots-clés personnels dans l’outil.

Au début, on voulait seulement laisser la possibilité d’ajouter des mots-clés au pot commun, à raison de 5 mots-clés, mais avouons-le très clairement, c’était naze.

#seobserver 99HT -> 5 mots-clés perso, comment ca me bloque psychologiquement

— FoxmiX (@foxmix7) 17 Novembre 2014

Alors on a réfléchi, retourné le problème dans tous les sens, et finalement on s’est dit que le mieux c’était tout simplement de multiplier ce chiffre par 30.

Mais on s’est aussi dit que certains n’avaient pas forcément besoin de monitorer tous leurs mots-clés tous les jours (notamment pour la longue traîne).

Donc on a décidé de vous laisser le choix, c’est pourquoi nous vous proposons une large gamme de fréquence de relevé de positions : moins vous les monitorez souvent, moins vous consommez de crédits. Cela vous permettra d’optimiser votre nombre total de mots-clés relevés.

Par exemple pour le prix d’1 mot-clé relevé tous les jours j’obtiens :

- 2 mots-clés relevés tous les 2 jours,

- 3 mots clés monitorés tous les 3 jours,

- 7 mots clés tous les 7 jours et ainsi de suite.

Voici le détail des crédits suivant les plans :

- Plan à 99 euros => 150 kws (ou 300 mots-clés tous les 2 jours, 1050 tous les 7 jours, 1500 tous les 10 jours, 2100 tous les 14 jours ou 4500 tous les 30 jours).

- Plan à 199 euros => 500 kws,

- Plan à 499 euros => 2000 kws.

Pour les personnes qui sont abonnées depuis ces deux derniers mois, un bonus vous sera évidemment appliqué pour vous remercier de votre confiance.

Pour les nouvelles personnes qui souhaiteraient s’inscrire, j’offre également un petit bonus pendant 24h sur votre nombre de mots-clés.

Beaucoup de nouveautés arriveront dans les prochaines semaines, stay tuned

A très vite.

Etude Google Penguin 3.0 – Octobre 2014

Attention, il s’agit d’une étude temporaire « brute » sans analyse, les fichiers seront mis à jour lors des prochains jours afin d’avoir plus de recul.

Cette nuit, samedi 18 Octobre 2014, une importante mise à jour est arrivée, et tous les indices portent à croire qu’il s’agit de Google Penguin.

Nous avons voulu être les premiers à vous proposer une étude sur les gagnants et perdants sur un échantillon représentatif de 3000 mots-clés de notre base de données sur google fr.

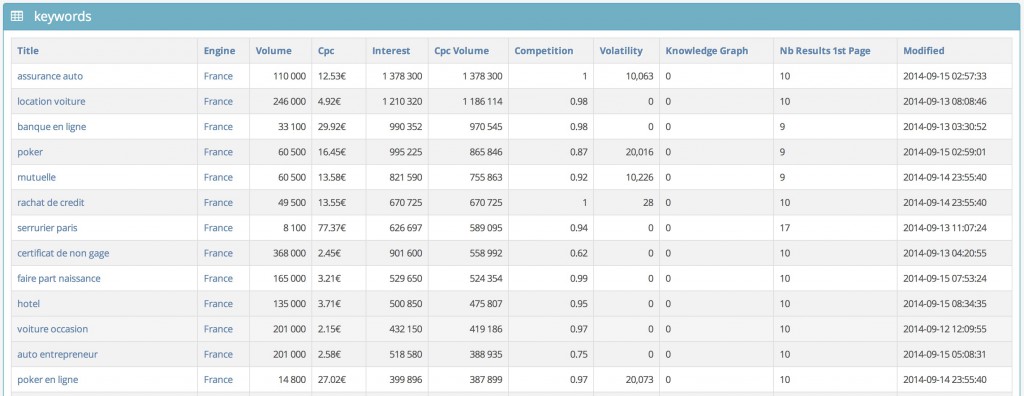

Méthodologie

Choix des mots-clés

Ces 3000 mots-clés se veulent représentatifs du web français, et ont été choisis en prenant les 3000 premiers résultats de la base adwords avec la formule : volume x cpc x concurrence SEA, afin de se débarasser des mots-clés de type « marque ». Même si la source d’origine reste Google Adwords et qu’elle est forcément biaisée, elle nous semble néanmoins assez fiable, avec une analyse visuelle rapide.

Choix des sites étudiés

Pour nous concentrer sur les gros mouvements, nous avons conservé uniquement les sites ayant un mouvement, positif ou négatif de plus de 5 places. Etant donné que les premières pages sont celles où il y a habituellement le moins de mouvements, nous avons également filtré pour ne garder que les sites qui ont une position de départ ou d’arrivée inférieure ou égale à 30 (3 premières pages).

Choix des métriques annexes

Notre politique depuis le début est de s’intéresser non seulement aux rankings, mais également aux facteurs de rankings, et comme Penguin concerne des problèmes liés au linking, nous avons voulu inclure des données de base en matière de linking à savoir :

Trust Flow : évaluation de la « qualité » du ranking.

Citation Flow : évaluation du volume du ranking.

Nombre de domaines référents : évaluation de la notoriété du site.

Ancres exactes : nombre de domaines uniques et de pages qui contiennent un lien avec l’ancre exacte sur le mot-clé visé

Ancres larges : nombre de domaines uniques et de pages qui contiennent un lien dont l’ancre contient le mot-clé visé

Ces éléments permettent de repérer rapidement d’un seul coup d’oeil les sites potentiellement problématiques, afin de démarrer une investigation plus profonde.

Date des relevés

Les relevés du 17 Octobre 2014 ont été effectués de 1h à 9h du matin.

Les relevés du 18 Octobre 2014, quant à eux ont été effectués de 10h à 19h afin d’attendre que la mise à jour soit uniforme et déployée depuis plusieurs heures.

Mise à jour : les relevés de la mise à jour ont eu lieu le 20 Octobre 2014, de 1h à 9h du matin.

Précisions

Cette étude est pour l’instant « brute » et est disponible sous la forme d’un fichier csv et d’un fichier excel. Nous n’avons pas assez de recul et tous les résultats sont à prendre avec beaucoup de précautions, car les résultats ne sont peut-être pas encore définitifs.

Télécharger les données brutes

N’hésitez pas à nous remercier sur Twitter, ça nous fera plaisir @SEObserver_fr

Excel : fichier encodé en ISO-8859-1

CSV : fichier encodé en UTF-8

Lire mon analyse

Au-delà de la donnée brute que vous pouvez analyser librement et gratuitement, vous pouvez retrouver l’analyse effectuée sur quelques exemples du fichier sur le site du journaldunet.com.

Liste d’attente

Vous aussi inscrivez-vous pour ne rien louper de l’actu SEO et profiter d’avantages exclusifs lors de la sortie publique de SEObserver, entrez votre email ci-dessous, vous ne le regretterez pas.

Demo de l’Extension Chrome SEObserver

Dans cette vidéo de 3 minutes, vous pouvez voir un aperçu du fonctionnement de l’extension chrome de SEObserver.

Vous avez également un aperçu de la veille quotidienne des backlinks (les nouveaux backlinks s’ajoutent en haut de la pile). Les champs avec une horloge sont ceux qui sont en train d’être mis à jour.

N’oubliez pas, pour être parmi les premiers à profiter de l’ouverture de SEObserver au public, inscrivez vite votre adresse email dans la liste d’attente ci-dessous.

SEObserver, c’est quoi ?

Nous y voilà enfin.

Les premières contractions ont commencé.

Le projet SEObserver qui a mis tant de mois à grandir, grossir va enfin voir le jour. Comment va-t-il être ? Et surtout, comment vont l’accueillir les gens ? Plein de questions en suspens.

Mais la première, et sûrement la plus importante : SEObserver, c’est quoi ?

La frustration de tout SEO

Comme la plupart des projets, SEObserver est né d’une frustration. La frustration de devoir se battre contre un géant, Google, sans connaître précisément ses points faibles en temps réel.

Egalement, la frustration de voir des sites arriver au sommet des rankings avec peu d’efforts et de devoir passer des heures à étudier leur stratégie.

Enfin, la frustration la plus insupportable : devoir supporter les conseils inutiles et quasi-insultants de l’équipe qualité de Google, des gens n’ayant jamais référencé et n’ayant jamais vécu de leurs propres sites, sans savoir véritablement ce qui fonctionne. « Faîtes du contenu de qualité. », « Don’t be evil ». Oui, oui…

L’outil SEO idéal

Je me suis donc mis en quête d’un outil idéal pour étudier, espionner et finalement contrôler le père Google.

L’outil idéal d’un point de vue technique pour vérifier concrètement ce qui marche et ce qui ne marche pas, c’est selon moi un outil :

- permettant de suivre les rankings de tous les sites à l’échelle du web, ou presque

- et permettant de suivre également tous les changements onsite/offsite/sociaux pour voir dans les faits ce qui a un impact.

Finalement, l’outil qui manquait cruellement jusqu’à présent, c’est une tour de contrôle qui détecte tous les changements importants dans les SERPs et qui donne la bonne info au bon moment.

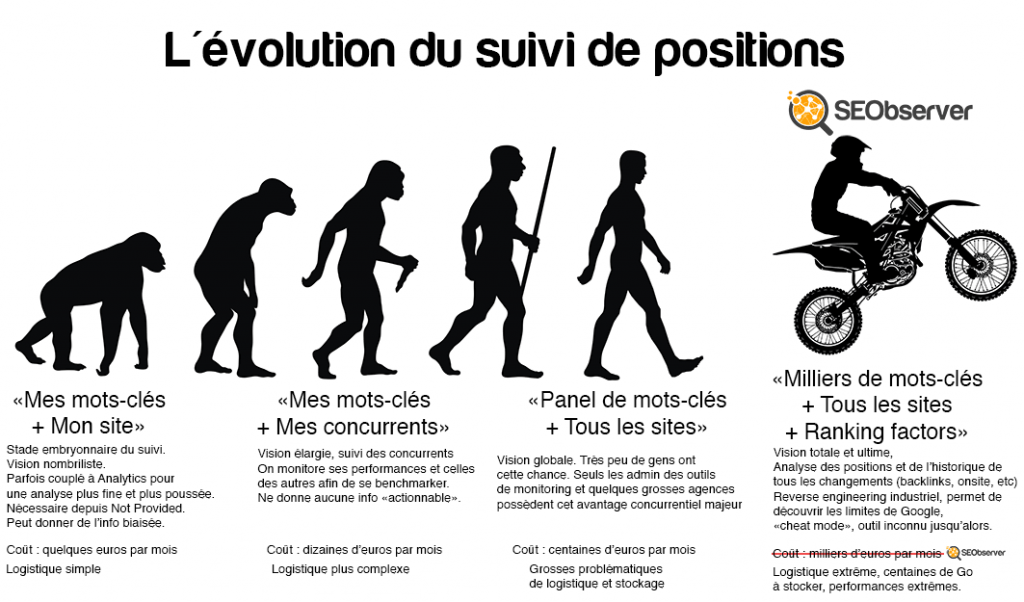

Attention, je ne parle pas d’une info ultra sommaire de type « tel concurrent est passé de la place 4 à la place 3 sur pizza au chocolat pas chère nantes ». Ca, ça s’appelle du suivi de position classique et on le connaît tous plus ou moins.

Je parle d’une info vraiment, vraiment pertinente, du genre :

- tel site s’est fait dézinguer sur tel mot-clé qui rapporte au premier 2000€/jour,

- tel concurrent a créé un backlink à tel endroit hier soir,

- voici en temps réel la liste de tous les derniers backlinks qui ont été créés par les 20 premiers sites sur la thématique « rachat de crédit »,

- tel concurrent a bondi dans les SERPs, et cela s’explique par un changement de title il y a 3 semaines et une campagne de backlinks commencée il y a 2 mois à base de commentaires sur des sites wordpress.

Vous voyez de quoi je parle ?

En fait, l’idée c’est vraiment de partir dans l’état d’esprit d’un hacker avec sa proie : l’étudier, l’analyser et « casser » son code pour en faire ce qu’on en veut.

Google nous espionne tellement au quotidien que finalement, espionner l’espion, c’est de bonne guerre, non ?

Voici SEObserver

Je me suis alors mis en tête de monitorer non pas une dizaine, ni une centaine, mais plusieurs dizaines de milliers de mots-clés. Ainsi, de cette manière je pourrai avoir un échantillon représentatif des niches les plus importantes au niveau SEO.

J’ai donc commencé à scraper, ou plutôt « monitorer » Google comme disent les patrons de startup.

Ensuite, une fois un site dans le viseur, j’ai décidé de m’intéresser aux deux facteurs essentiels en matière de SEO : le onsite et le offsite.

La partie offsite a été plutôt facile, puisqu’il suffisait d’un gros fournisseur de données (données qui coûtent très, très cher !) pour sortir une liste de backlinks à catégoriser pour aller plus loin :

- analyse du CMS,

- récupération du pagerank,

- vérification si la page est indexée ou non,

- vérification du nombre de liens sortants

- récupération du nombre de partages sur les réseaux sociaux.

Avec une option pour catégoriser en mode manuel puis semi-auto pour savoir quel est le type de backlink (naturel, acheté, spam commentaire/forum, etc).

La partie onsite a donné plus de fil à retordre. Il est en effet très difficile de sortir des infos facilement catégorisables pour du onsite, je me suis donc rabattu sur les éléments les plus simples et les plus importants :

- changements de balise title

- évolution du nombre de mots sur la page (ajout/retrait de contenu)

- nombre de pages indexées

L’union fait la force

Le vrai gros problème dans tout ce que je viens de détailler, c’est le coût.

Si scraper Google coûte horriblement cher, pour ne pas dire un bras (plusieurs centaines d’IP nécessaires pour scraper plusieurs dizaines de milliers de mots-clés quotidiennement ou presque), l’accès aux données de backlinks auprès des leaders sur le marché coûte un autre bras.

Pourtant, un scrap est un scrap, et une fois le travail réalisé, il ne coûte pas beaucoup plus cher de donner l’accès à 1 ou 100 personnes.

L’idée a donc été de frapper un grand coup et de créer une sorte de « Groupon » du monitoring de positions : au lieu d’être sur un modèle « 1 projet = 1 euro », j’ai préféré effectuer un scrap sur le top 50 000 (et très bientôt top 100 000) mots-clés les plus pertinents selon adwords, avec un élément radicalement différent : chaque client qui paye un abonnement peut accéder à la totalité de la base de données et à tout l’historique.

Et s’il veut suivre des mots-clés qui ne sont pas encore présentes, il peut simplement les ajouter au corpus.

Concrètement, cela donne quoi ?

L’outil tel qu’il fonctionne à l’heure actuelle possède trois modules :

Une base de recherche avancée de mots-clés, avec possibilité de télécharger toute la base en csv. Cette donnée à elle toute seule vaut plusieurs centaines d’euros.

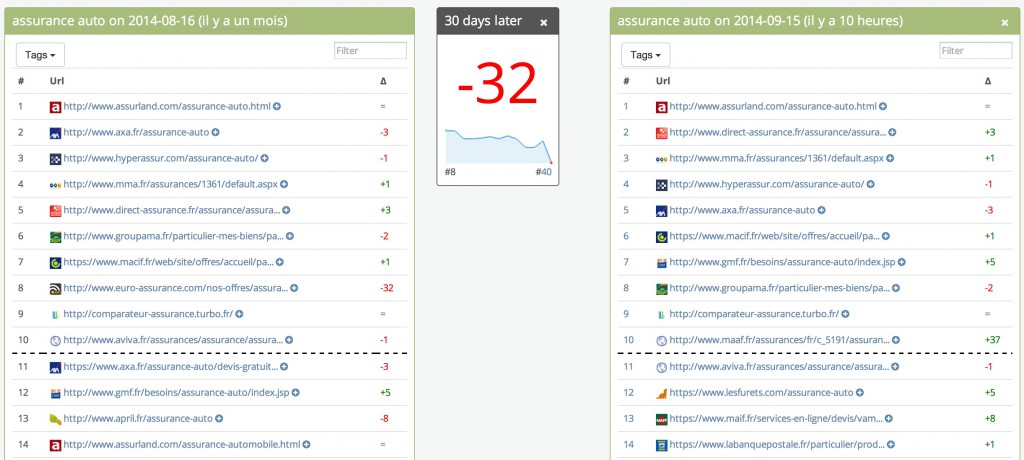

Un écran de machine à remonter le temps dans les SERPs. Vous avez la vision des SERPs à deux dates données, et lorsque vous passez au-dessus d’un site, vous voyez son évolution.

Un écran de détail, où vous affichez 1 à 5 courbes de rankings de sites et la liste des changements opérés par ces mêmes sites, avec des filtres possibles.

Et évidemment un écran avec la liste des derniers backlinks créés de tous les sites suivis (+ un widget qui sera ajouté sur la home).

Le tout sans aucune restriction de consultation, en tout cas pour les data de rankings, dans les limites du raisonnable.

Ok, ok, mais les accès ouvrent quand ?

Il manque deux détails à régler avant de pouvoir ouvrir les inscriptions en bonne et due forme :

- la finalisation du deal avec le fournisseur de données pour les backlinks à savoir MajesticSEO. La plupart des outils à l’heure actuelle vous proposent de connecter votre compte Ahrefs ou MajesticSEO à leur outil, ce qui fait que vous vous retrouvez à payer plusieurs abonnements.

Je veux procéder différemment et vous fournir directement ces données, ce qui est assez compliqué car cela me place dans une position de « revendeur » de données, avec plein d’implications business pour ces fournisseurs, qui génèralement n’aiment pas du tout cela. Ils préfèrent évidemment avoir un « lien direct » avec le client final plutôt qu’avec moi. Bref, les négociations sont serrées mais un deal a été trouvé. Je suis donc en train de valider les derniers détails qui prennent plus de temps que prévu. - la finalisation de la rédaction et la validation de mes CGV et CGU par mon avocat. Tâche chronophage et ingrate, mais absolument nécessaire pour lancer un outil. Je veux pouvoir protéger les utilisateurs qui peuvent vouloir passer des heures sur l’outil à faire de la vraie R&D, mais me protéger contre les scrapeurs, non seulement techniquement mais aussi légalement.

Les accès vont ouvrir progressivement, par batch de 10-20 utilisateurs afin de ne pas surcharger le serveur et d’analyser la montée en charge. Les premiers arrivés seront donc les premiers servis.

Pour profiter en priorité de l’ouverture de SEObserver, inscrivez votre email ci-dessous.

A très vite pour le pot de naissance