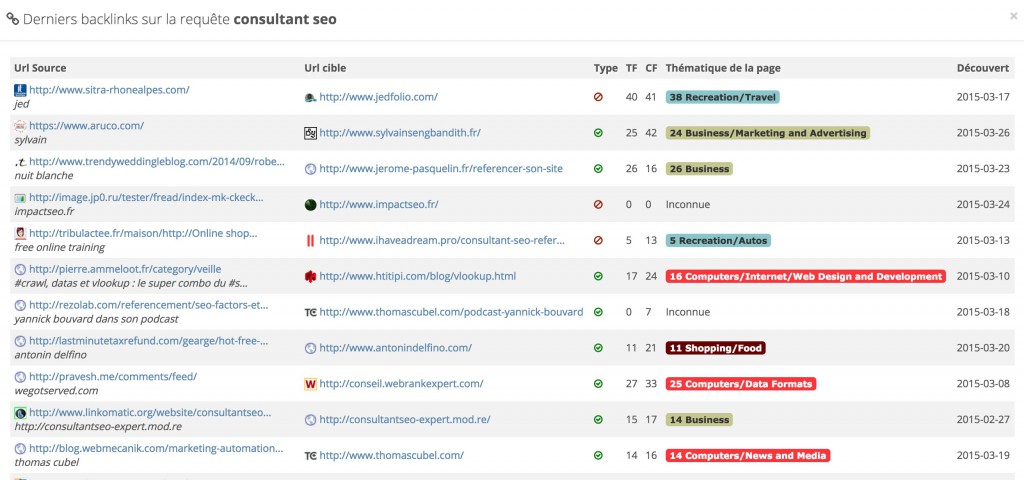

En bref: deux fonctionnalités exclusives font leur apparition dans l’affichage des top backlinks, qui vont définitivement changer votre manière d’analyser le linking d’un site :

- nous ajoutons l’information de l’indexation de l’URL en cours,

- et nous affichons le nombre de mots-clés sur lesquels l’url source du backlink se positionne.

Les outils d’analyse de backlinks passent à côté de l’essentiel : est-ce que Google aime mon site ?

Chaque outil de backlink essaie d’apporter à l’utilisateur une manière de qualifier un lien, et de le catégoriser pour lui permettre de lister les liens qui ont un vrai impact sur le positionnement.

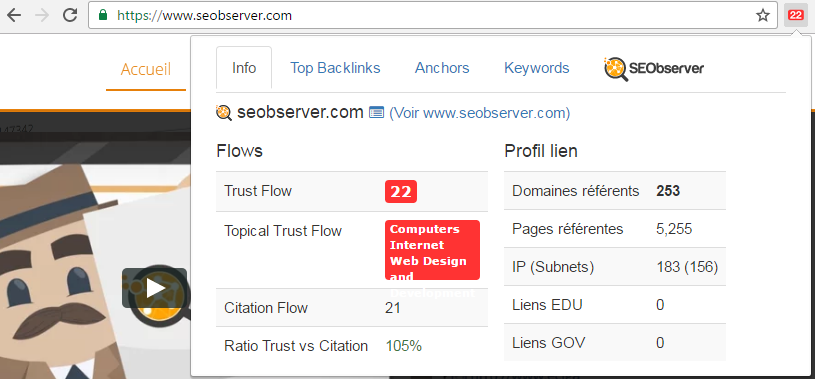

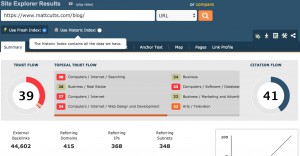

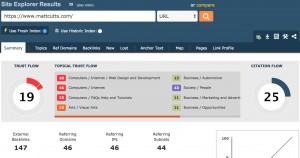

L’indicateur le plus célèbre et le plus efficace selon nous pour évaluer la qualité d’un lien reste le TrustFlow, les autres indicateurs allant de la tentative intéressante mais avec un index trop faible (Domain Authority), à la vaste blague (Domain Rank).

Mais peu importe la qualité du TrustFlow, cet indicateur reste un élément conçu par une entreprise indépendante de Google qui essaie certes de se rapprocher le plus possible du mode de calcul du Pagerank, avec une surcouche de qualité, mais qui n’est pas Google.

Nous nous sommes donc posés la question : malgré la grande qualité de cet indicateur, comment pourrait-on améliorer le TrustFlow de Majestic pour lui rajouter la plus belle surcouche « Google » possible ? Comment réussir à vérifier qu’un lien est bel et bien pris en compte par Google ? Comment éviter de passer à côté de l’essentiel en se focalisant uniquement sur le TrustFlow, alors que parfois, la page n’est même pas prise en compte par Google ?

Certes, il est impossible d’avoir un accès exhaustif à la donnée stockée chez Google, mais certains éléments permettent d’avoir un aperçu, un avant-goût de comment Google perçoit un site.

Les deux éléments les plus connus sont :

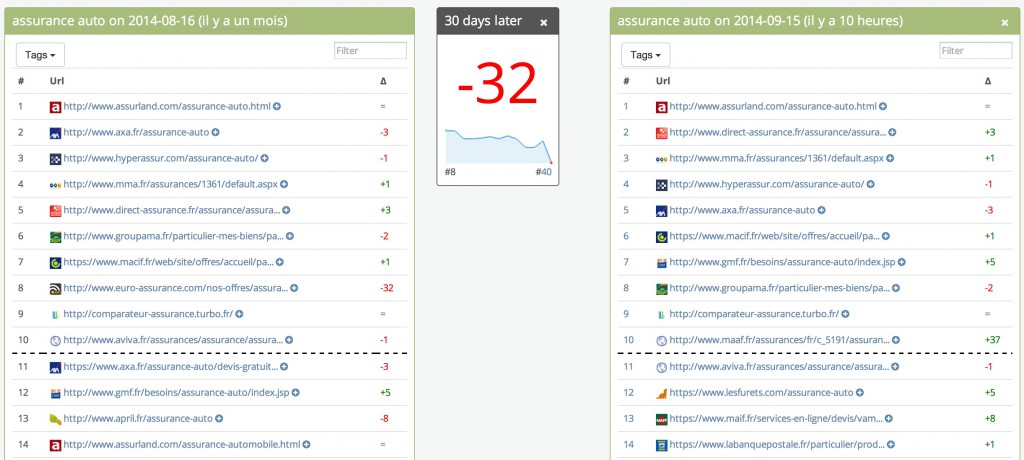

- la page qui me fait un lien est-elle indexée ? Si ce n’est pas le cas, ce backlink n’est probablement pas pris en compte.

- la page qui me fait un lien se positionne-t-elle sur des mots-clés concurrentiels ? Si oui, c’est une preuve que le lien est d’excellente qualité (attention, l’inverse n’implique pas que le lien est forcément « mauvais »).

Nous avons toujours pris en compte dans notre approche la fusion la plus fluide possible entre les backlinks et les rankings.

C’est pourquoi nous avons intégré une feature unique dont nous ne pouvons déjà plus nous passer à l’usage: la vérification de l’indexation des backlinks et l’affichage du nombre de mots-clés de chaque url source.

D’autre part, une approche propre à Majestic consistait à afficher dans les backlinks les liens de type flux rss, même s’ils ne sont jamais indexés par Google. Nous avons également résolu ce souci en prenant le lien le plus puissant du domaine en cours, sans que celui-ci ne soit un feed rss.

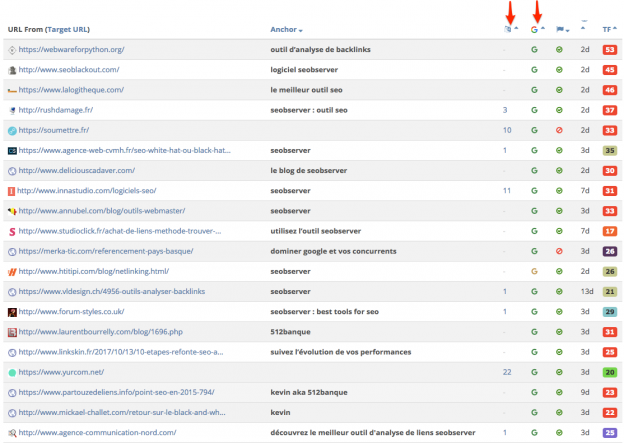

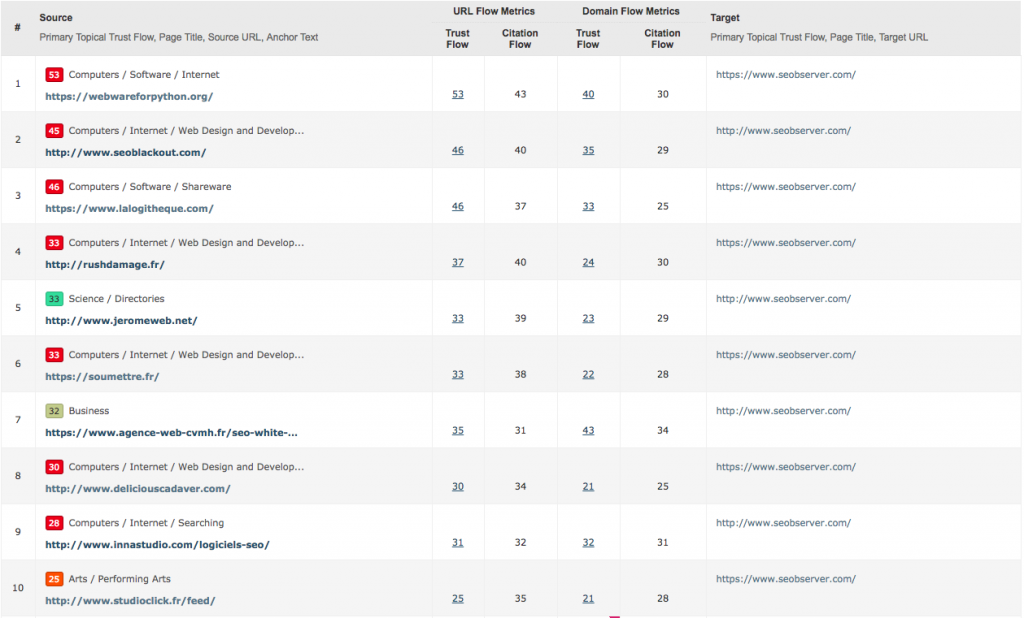

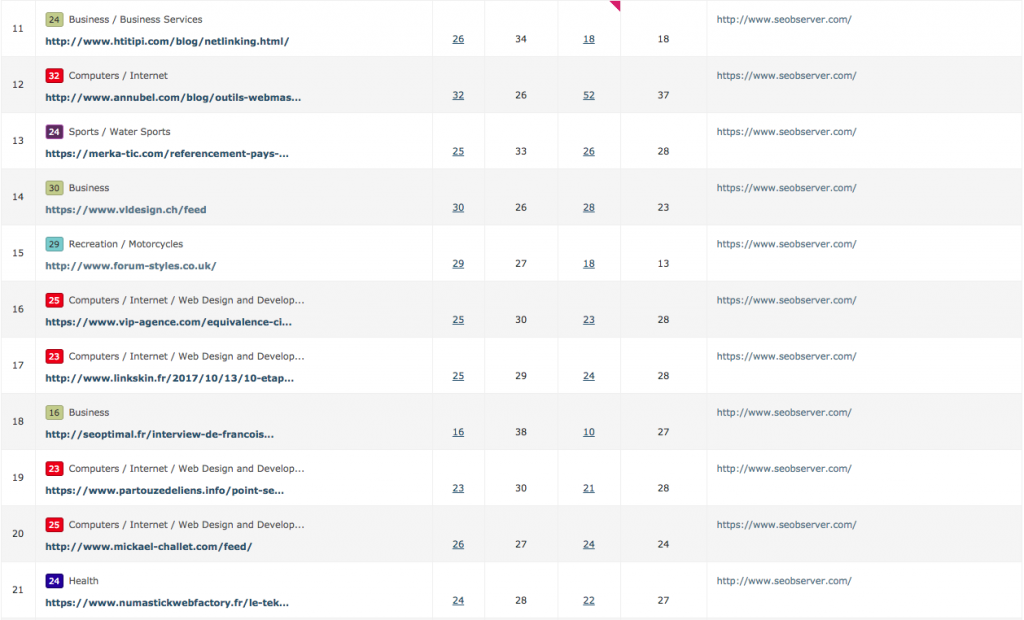

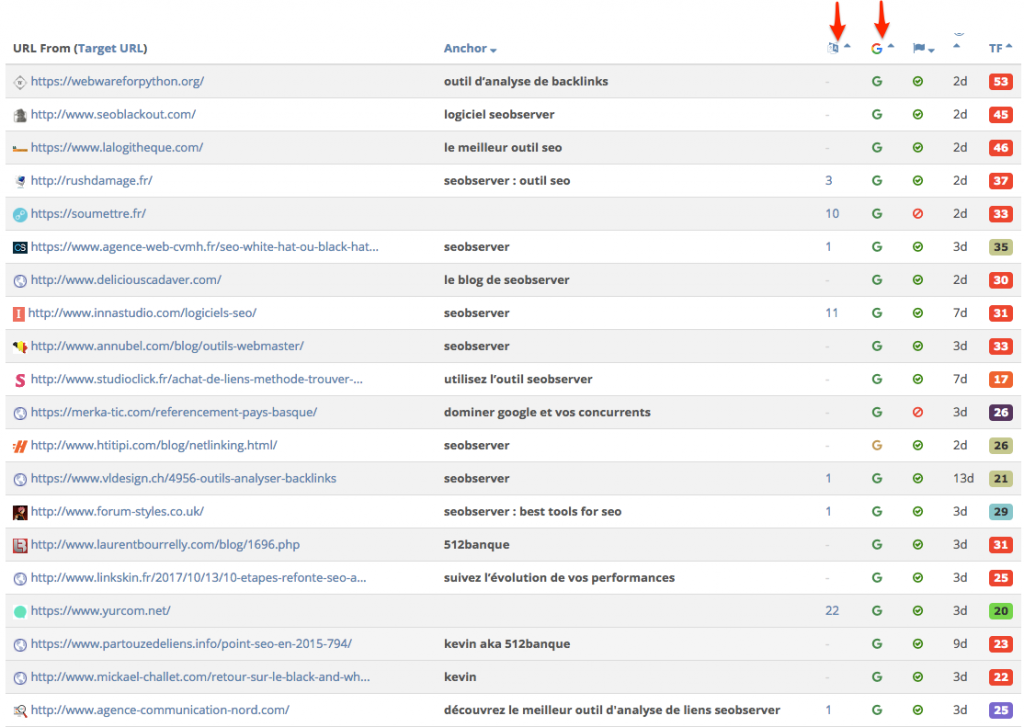

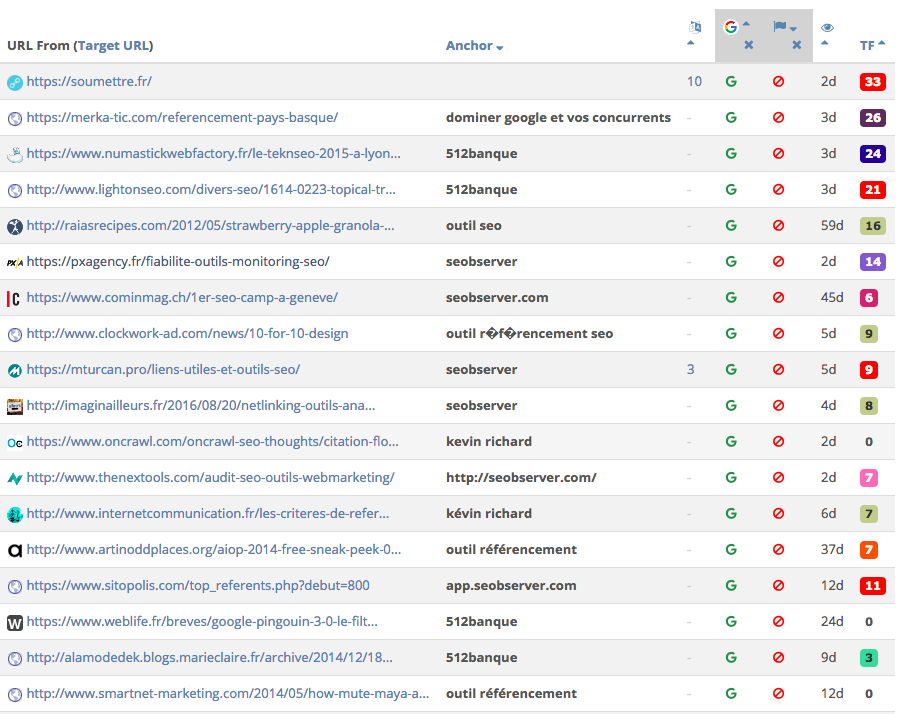

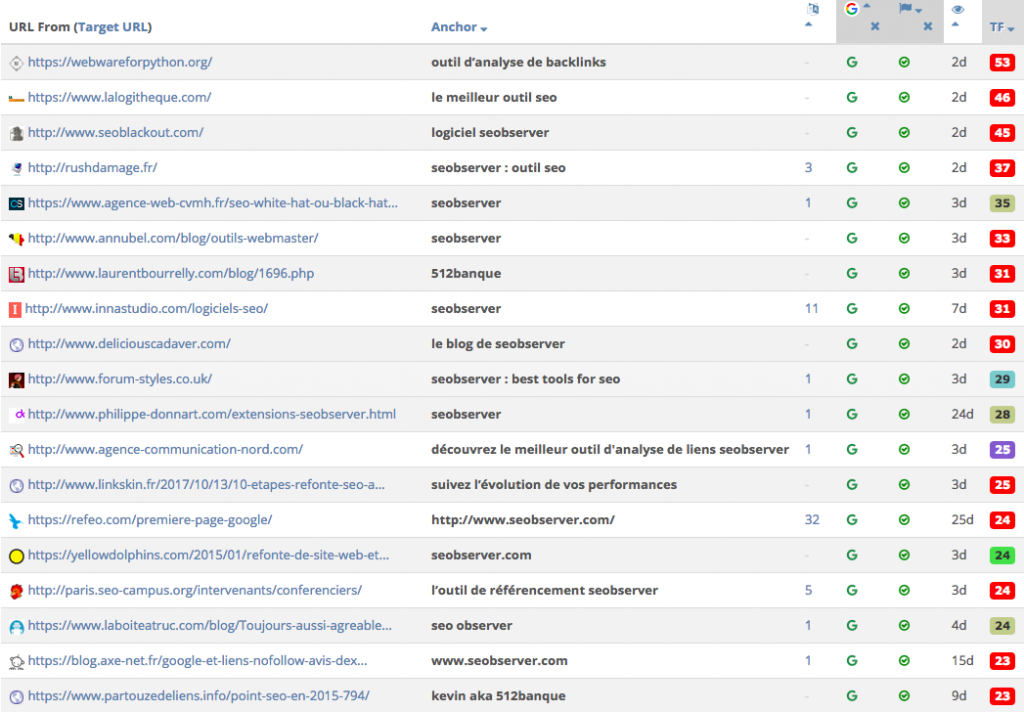

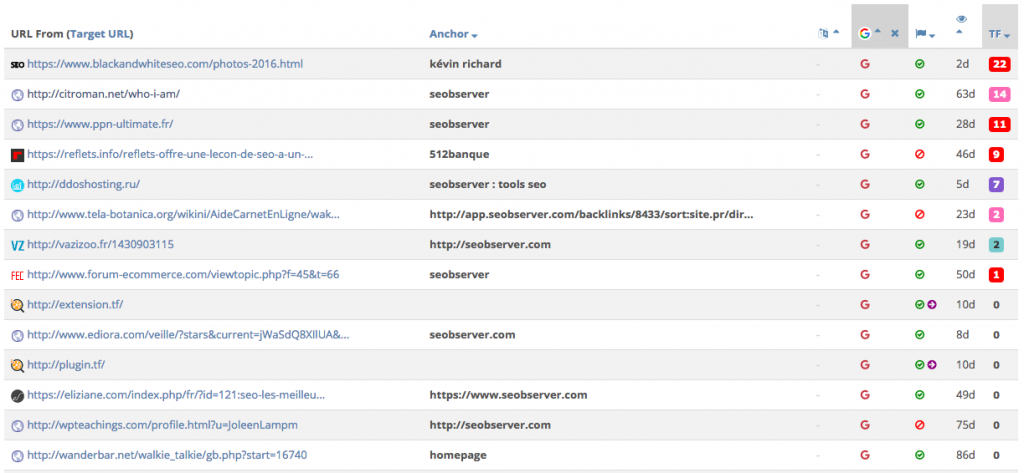

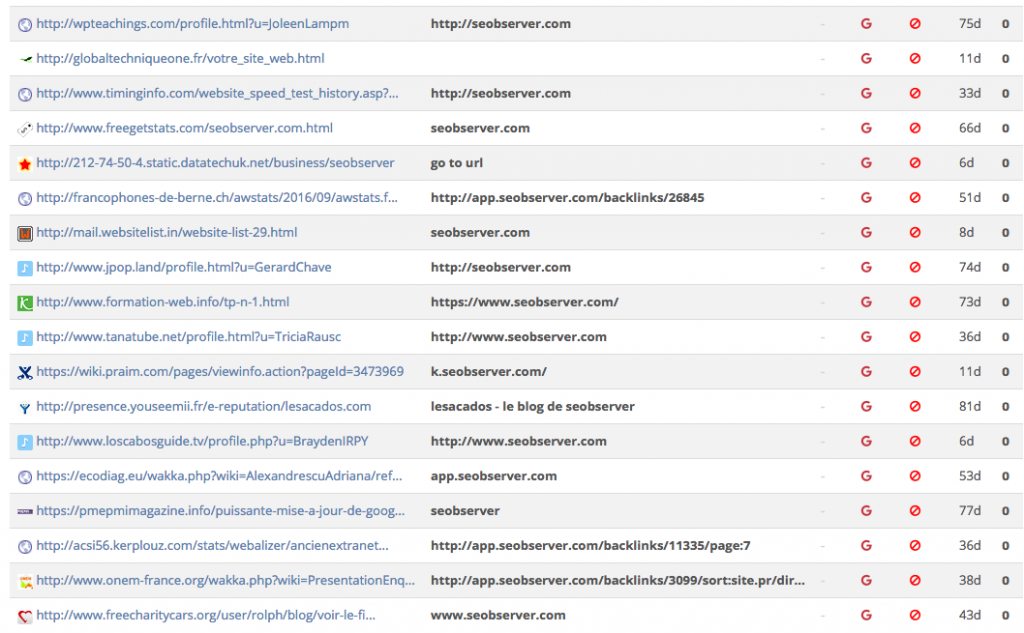

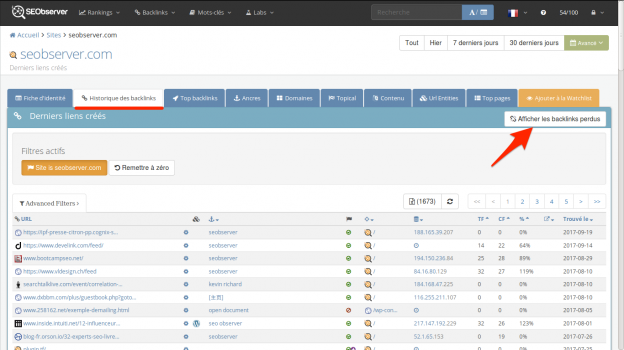

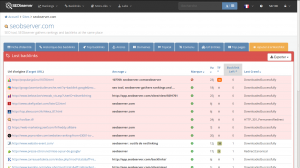

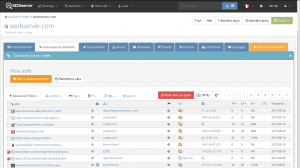

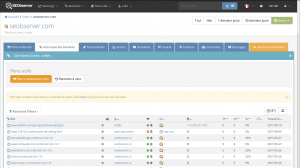

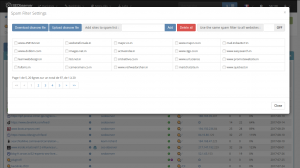

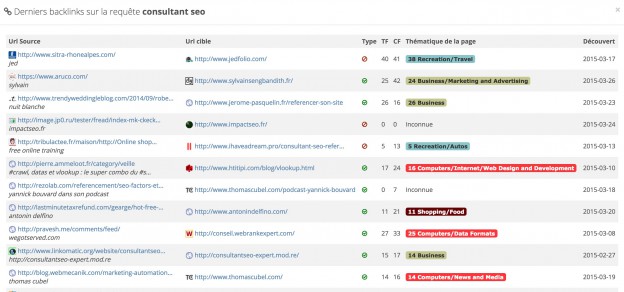

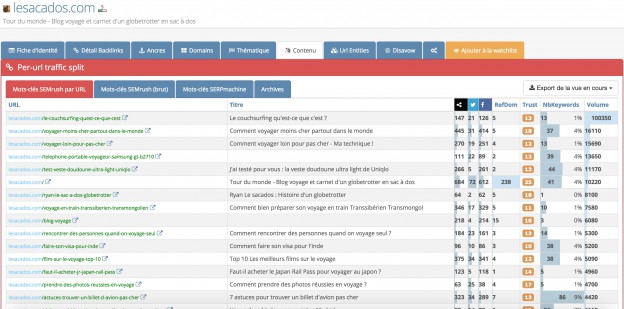

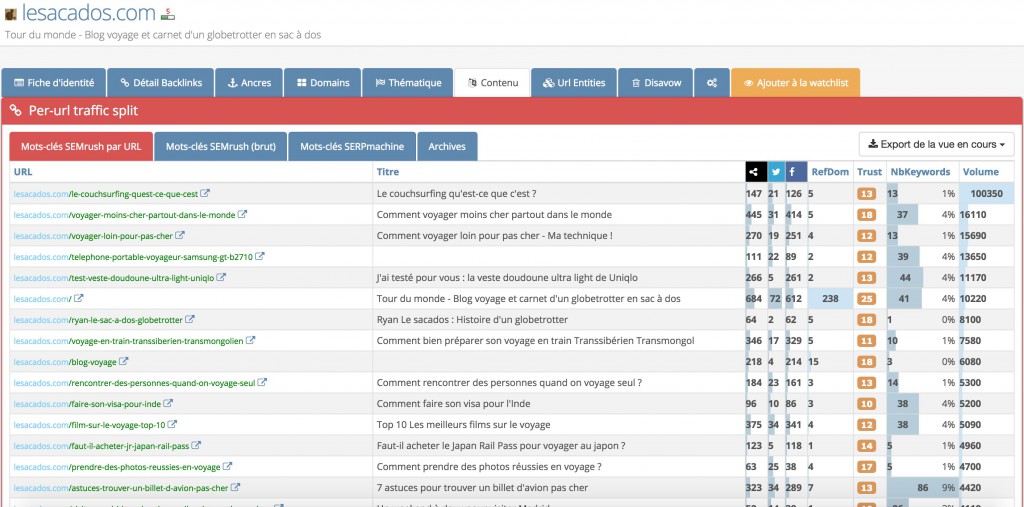

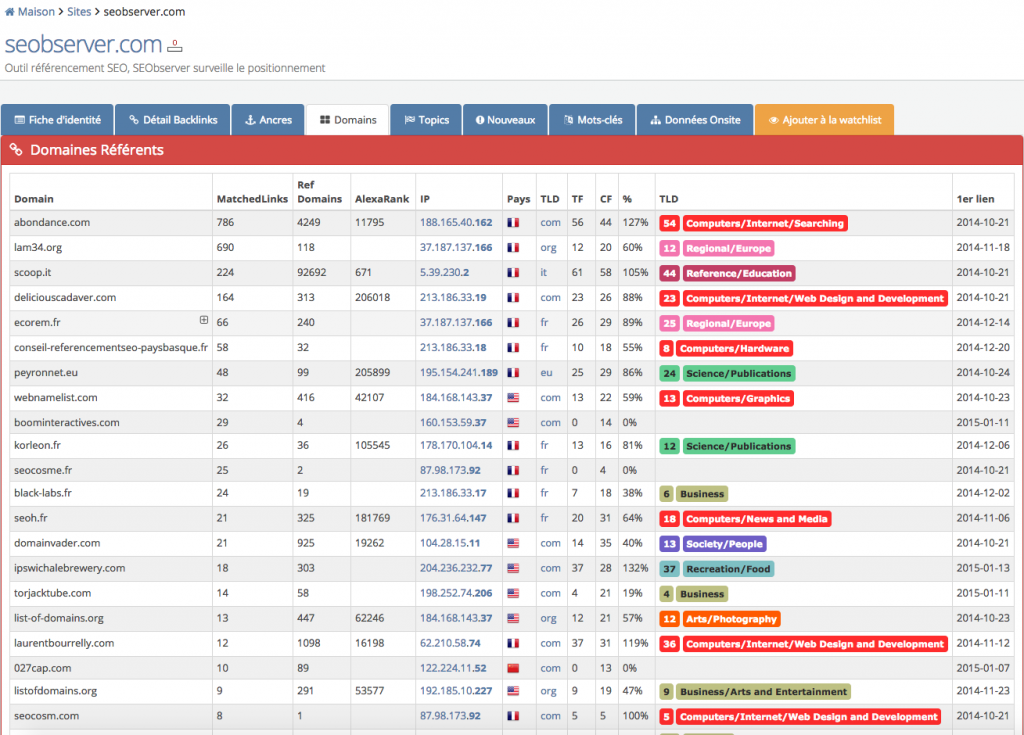

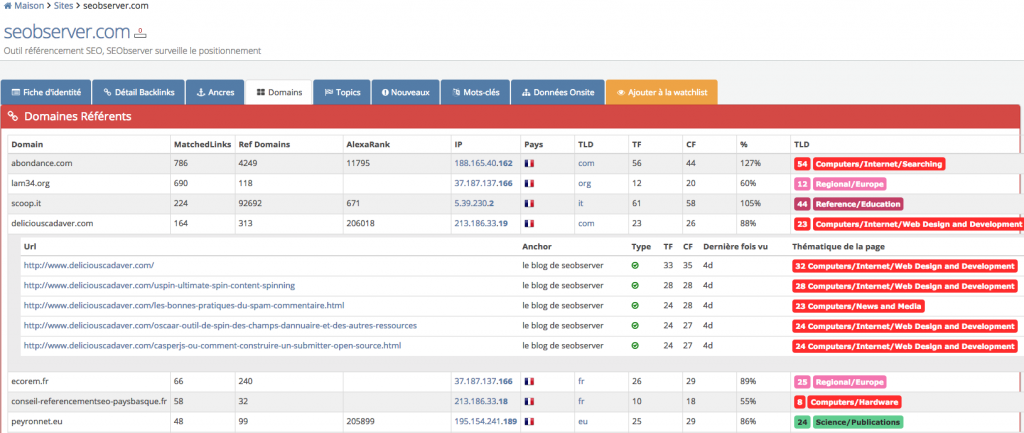

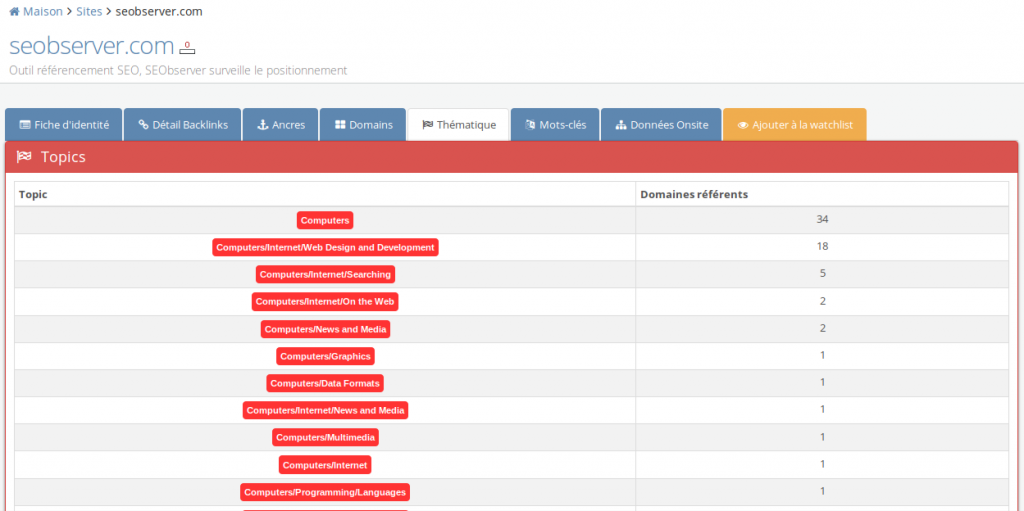

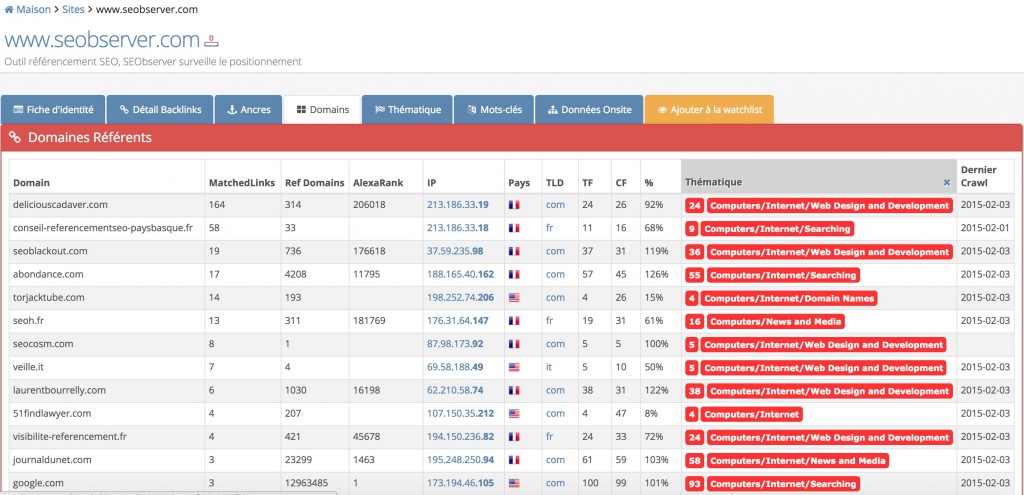

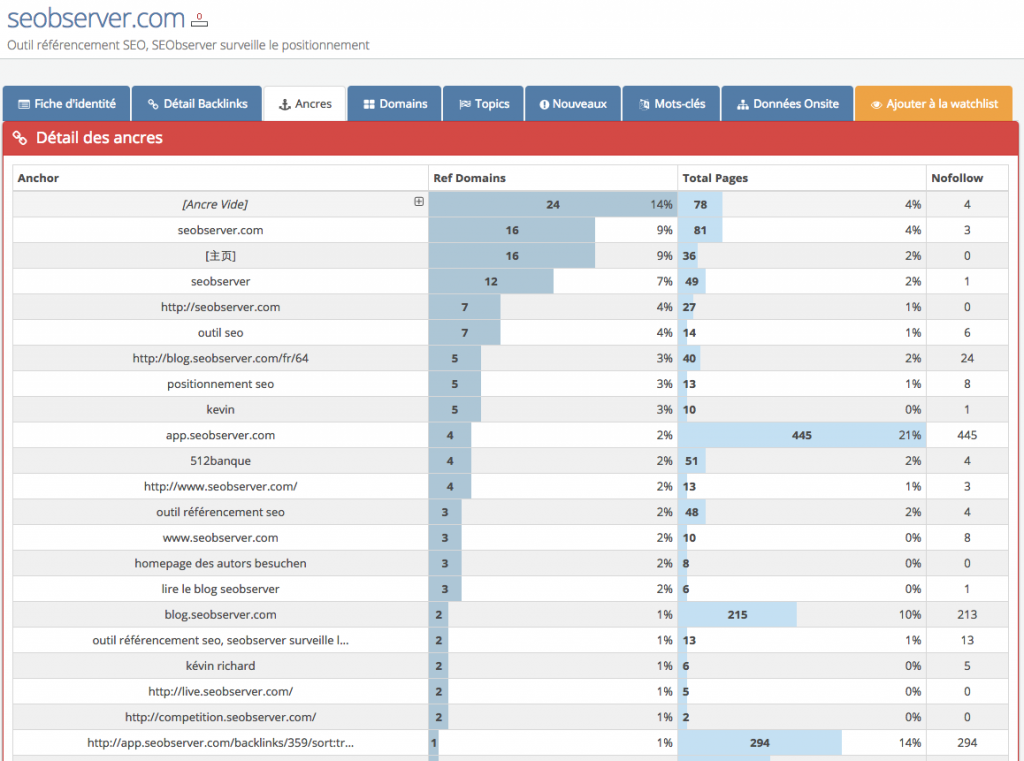

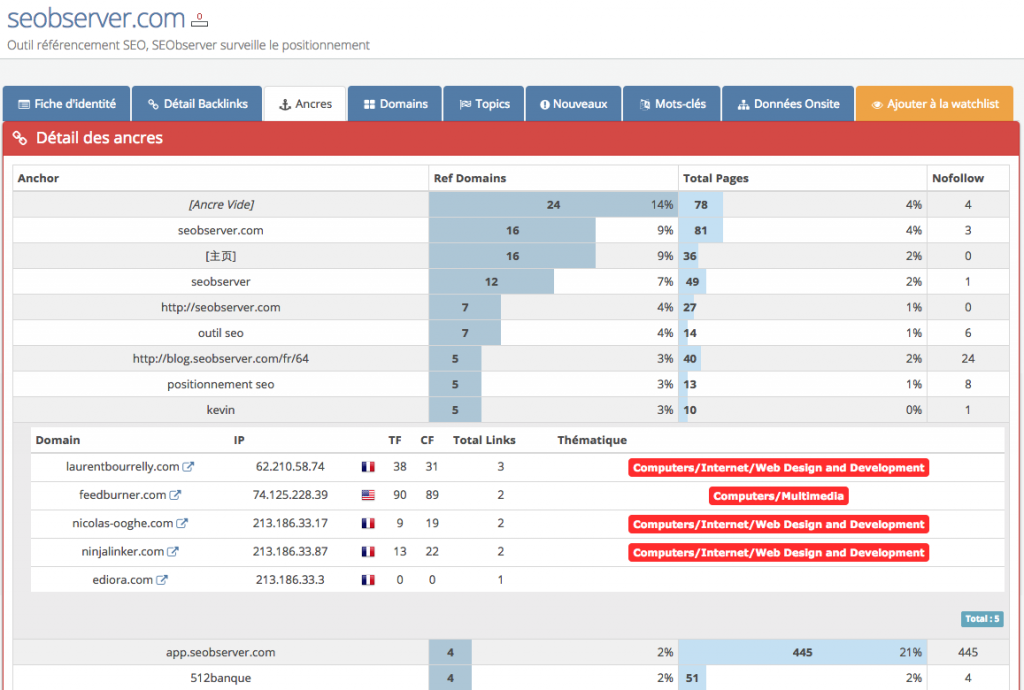

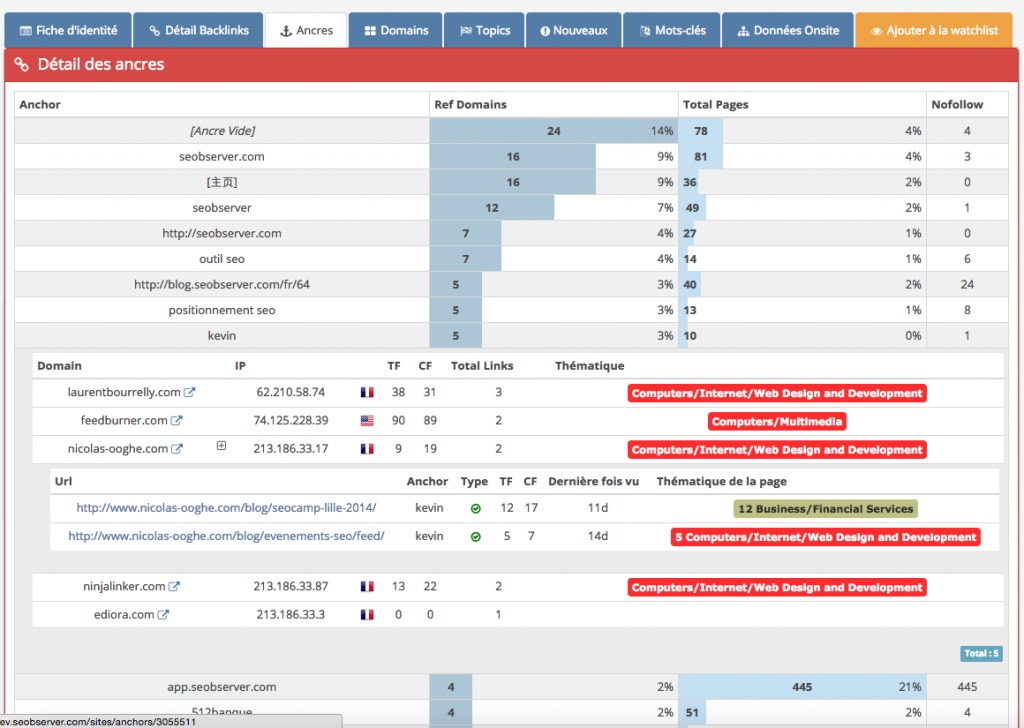

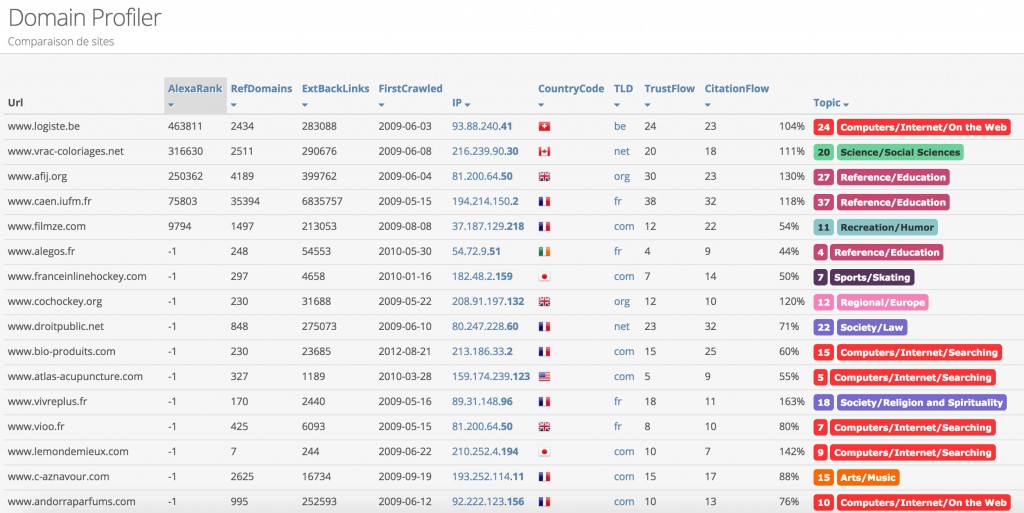

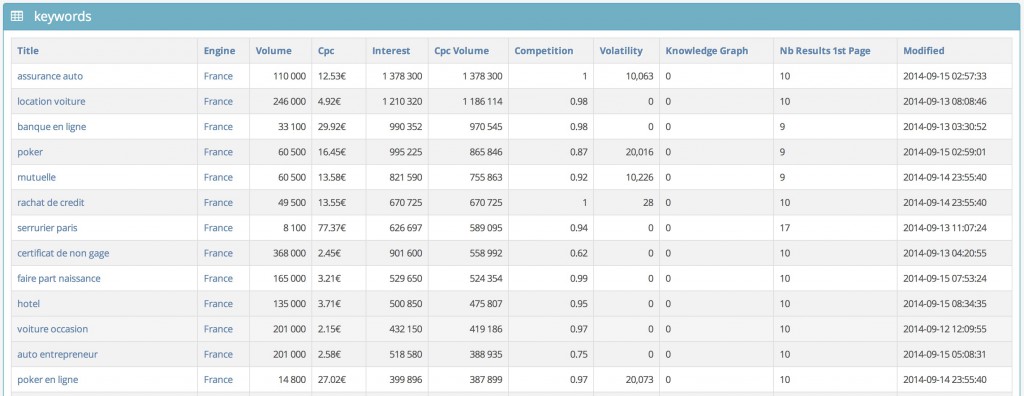

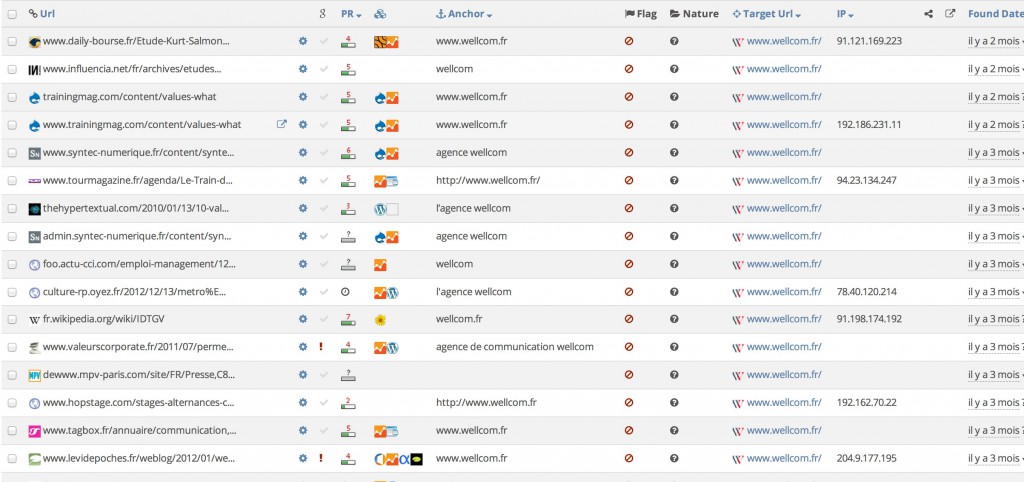

Comparons concrètement les vues proposées par Majestic et SEObserver pour voir à quel point l’info apportée est capitale. Voici la vue des top backlinks de seobserver.com, selon Majestic (nous avons simplifié afin de mettre en avant les infos cruciales) :

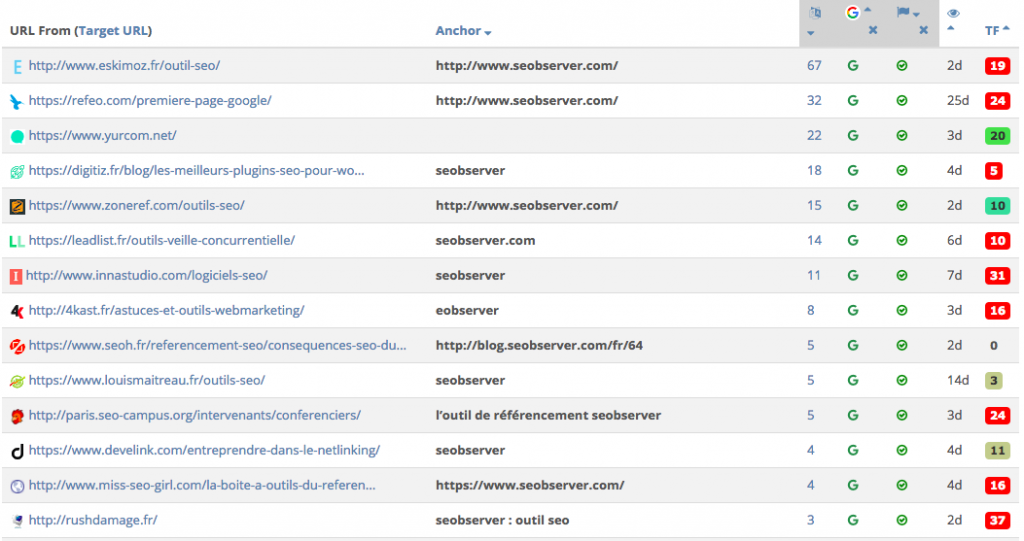

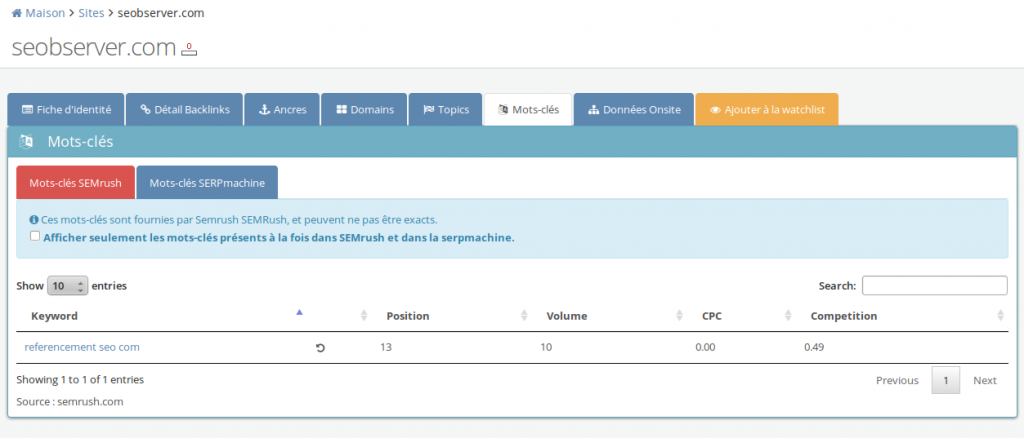

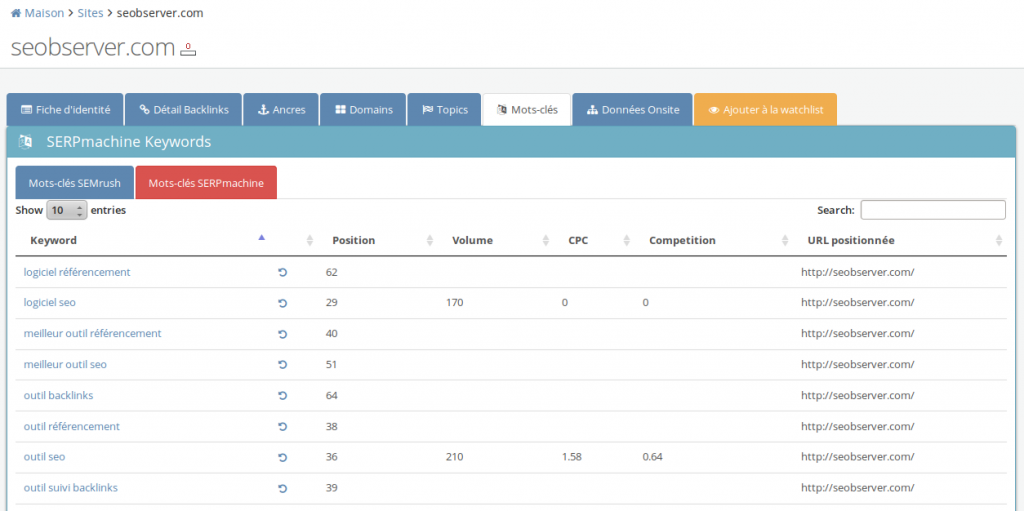

On voit les deux colonnes avec le nombre de mots-clés sur lesquels se positionne la page, ainsi qu’une colonne pour vérifier que le backlink est bien indexé. Voici comment maintenant tirer pleinement parti de cette feature.

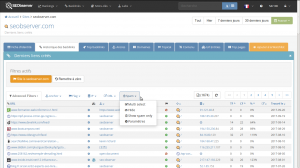

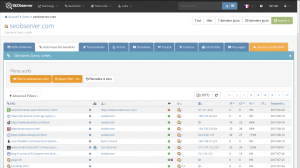

Exemple n°1 : les opportunités de liens : « sors moi seulement les backlinks en provenance de sites de bonne qualité »

Si c’est mon site : Je filtre tous les liens qui sont à la fois indexés et en nofollow, et je trie par TF négatif. Essayer de négocier pour obtenir un dofollow à la place. Si les pages rankent sur des mots-clés c’est encore mieux.

Si c’est vers un concurrent, réfléchir à comment je peux obtenir le même lien (ou faire en sorte que la page remplace le lien vers le site du concurrent par le mien ).

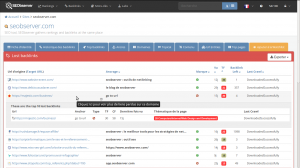

Exemple n°2 : trouver les pages stratégiques qui me linkent

Il s’agit de la crème de la crème de vos backlinks : fort TrustFlow, page indexée, ranke sur de nombreux mots-clés. Ces backlinks ont potentiellement incontestablement un fort impact sur mon positionnement.

Je dois faire en sorte de ne pas perdre ces liens, je devrais monitorer leur présence régulièrement. De même, si une de ces pages commence à perdre des mots-clés, du TrustFlow ou pire, être désindexée, cela devrait commencer à m’inquiéter (pas de souci, une feature arrive pour faire cela).

Exemple n°3 : trouver les sites qui ont un souci de ranking, qui me linkent

Je trie par TF décroissant, et je m’intéresse aux sites qui n’ont aucun mot-clé : peut-être qu’il s’agit de sites qui ne sont plus mis à jour, ou alors des expirés rethématisés. Ou des annuaires. Ou tout simplement des articles qui n’ont pas été optimisés pour ranker sur des mots-clés en particulier. Je pondère donc le TrustFlow de la page par ce que je réussis à trouver en creusant un peu (je peux par exemple choisir de pondérer à la baisse un TF qui ne ranke pas bien, mais il n’y a pas de règle).

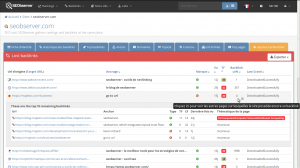

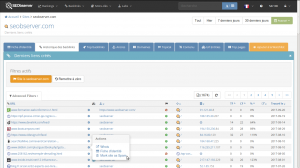

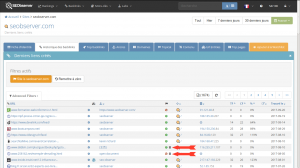

Exemple n°4 : trouver les sites blacklistés qui me linkent

Souvent, le combo fort TrustFlow + page non-indexée peut être révélateur d’un problème. C’est le cas pour les premiers liens de la liste ici. Mais cela peut être également deux causes, notamment une redirection qui a peu de puissance, ou bien une page volontairement non-indexée (une page catégorie par exemple).

Pas de conclusion hâtive (jamais d’ailleurs), il faut vérifier manuellement pour être sûr de ce qui se passe.

Exemple n°5 : trouver les sites de mauvaise qualité qui me linkent

Les sites/pages de mauvaise qualité ne seront pas indexées. Autant que je ne perde pas de temps avec eux. C’est généralement le combo « page non indexée » + faible TrustFlow. Si on ajoute à cela « lien en Nofollow », on obtient vraiment typiquement ce qui pollue la vue pour rien. Donc strictement aucun impact de ce type de liens, ceux qui sont superstitieux peuvent choisir de les désavouer quand même.

Voici les premières idées qui nous viennent des usages de cette feature, mais nous savons que nos utilisateurs sauront détecter des comportements particuliers à partir des différents éléments.

Une chose est sûre : après cette feature, il est littéralement impossible pour tout SEO de revenir à un autre type d’analyse de linking. Ne pas prendre en compte l’indexation des liens est, lorsqu’on a la possibilité de le faire, extrêmement dommage et peut nous induire en erreur.

Vraiment.

Merci à Fabien Raquidel et Paul Sanches qui ont su pendant de longs mois, revenir à la charge concernant cette feature.